2、Kafka高级

约 34180 字大约 114 分钟

2025-09-04

kafka消费者分区策略

kafka分区策略接口定义

// 分区分配策略的接口定义

public interface PartitionAssignor {

String name(); // 策略名称

Subscription subscription(Set<String> topics); // 消费者订阅信息

Map<String, Assignment> assign(Cluster metadata,

Map<String, Subscription> subscriptions);

}在消费者组中选择一个身份魏leader的主消费者,负责分区的分配策略计算;

kafka分区策略工作流程

RangeAssignor(范围分配器)- 默认策略

算法原理

public class RangeAssignor extends AbstractPartitionAssignor {

@Override

public Map<String, List<TopicPartition>> assign(

Map<String, Integer> partitionsPerTopic,

Map<String, Subscription> subscriptions) {

Map<String, List<TopicPartition>> assignment = new HashMap<>();

// 对每个主题独立分配

for (Map.Entry<String, Integer> entry : partitionsPerTopic.entrySet()) {

String topic = entry.getKey();

int numPartitions = entry.getValue();

// 获取订阅该主题的消费者

List<String> subscribers = getSubscribersForTopic(topic, subscriptions);

Collections.sort(subscribers); // 按consumerId排序

int numSubscribers = subscribers.size();

int partitionsPerConsumer = numPartitions / numSubscribers;

int consumersWithExtraPartition = numPartitions % numSubscribers;

// 分配逻辑

List<TopicPartition> partitions = partitions(topic, numPartitions);

for (int i = 0; i < numSubscribers; i++) {

int start = partitionsPerConsumer * i +

Math.min(i, consumersWithExtraPartition);

int length = partitionsPerConsumer +

(i + 1 > consumersWithExtraPartition ? 0 : 1);

assignment.get(subscribers.get(i))

.addAll(partitions.subList(start, start + length));

}

}

return assignment;

}

}分配实现

// 示例:主题A有7个分区,3个消费者

// 分配结果:

Consumer1: [A-0, A-1, A-2] // 7/3=2余1,前1个消费者多1个分区

Consumer2: [A-3, A-4]

Consumer3: [A-5, A-6]

// 计算公式:

// partitionsPerConsumer = 7 / 3 = 2

// consumersWithExtraPartition = 7 % 3 = 1

// Consumer1: start=0, length=2+1=3 → [0,1,2]

// Consumer2: start=3, length=2 → [3,4]

// Consumer3: start=5, length=2 → [5,6]优缺点分析

优点:

- 实现简单,计算效率高

- 同一主题的分区连续,适合顺序处理

缺点:

- 容易产生分配不均("头部重尾轻"问题)

- 主题数量多时,消费者间负载差异明显

- 消费者数量变化时,分配变动大

适用场景:

- 主题数量少

- 分区数能被消费者数整除

- 需要分区连续性的场景

RoundRobinAssignor(轮询分配器)

算法实现原理

public class RoundRobinAssignor extends AbstractPartitionAssignor {

@Override

public Map<String, List<TopicPartition>> assign(

Map<String, Integer> partitionsPerTopic,

Map<String, Subscription> subscriptions) {

// 1. 将所有主题的分区合并排序

List<TopicPartition> allPartitions = new ArrayList<>();

for (Map.Entry<String, Integer> entry : partitionsPerTopic.entrySet()) {

String topic = entry.getKey();

for (int i = 0; i < entry.getValue(); i++) {

allPartitions.add(new TopicPartition(topic, i));

}

}

// 2. 消费者按ID排序

List<String> consumers = new ArrayList<>(subscriptions.keySet());

Collections.sort(consumers);

// 3. 轮询分配

Map<String, List<TopicPartition>> assignment = new HashMap<>();

for (int i = 0; i < allPartitions.size(); i++) {

String consumer = consumers.get(i % consumers.size());

assignment.computeIfAbsent(consumer, k -> new ArrayList<>())

.add(allPartitions.get(i));

}

return assignment;

}

}分配案例

// 示例:2个主题,共6个分区,3个消费者

// 主题A: [A-0, A-1, A-2]

// 主题B: [B-0, B-1, B-2]

// 所有分区排序:A-0, A-1, A-2, B-0, B-1, B-2

// 轮询分配:

Consumer1: [A-0, B-0]

Consumer2: [A-1, B-1]

Consumer3: [A-2, B-2]

// 完美均衡!关键限制与问题

class RoundRobinLimitations {

/*

重要前提:所有消费者订阅相同的主题列表!

问题场景:消费者订阅不同主题

消费者1订阅: [A, B]

消费者2订阅: [A] // 只订阅A

分配结果可能不均衡,因为轮询基于所有主题的分区

*/

// 改进版本:考虑订阅差异

@Override

protected boolean isSupportedProtocol(Subscription subscription) {

// 需要检查所有消费者是否订阅相同主题

return true;

}

}优缺点分析

优点:

- 分配绝对均衡(订阅相同时)

- 实现简单

- 跨主题负载均衡

缺点:

- 要求所有消费者订阅相同主题(严格限制)

- 消费者订阅不同时,分配不均

- 重平衡时分区移动可能较多

适用场景:

- 所有消费者订阅相同的主题集合

- 需要严格负载均衡

- 主题数量多但分区数少

StickyAssignor(粘性分配器)

设计目标

设计目标(按优先级):

- 分配尽可能均衡

- 重平衡时最小化分区移动(粘性)

- 支持消费者订阅差异

解决的问题:

- RangeAssignor的头部重尾轻问题

- RoundRobinAssignor的订阅限制问题

- 频繁重平衡导致的分区抖动问题

算法实现原理

public class StickyAssignor extends AbstractPartitionAssignor {

// 核心算法:两步分配

@Override

public Map<String, List<TopicPartition>> assign(

Map<String, Integer> partitionsPerTopic,

Map<String, Subscription> subscriptions) {

// 步骤1:执行初始分配(使用RoundRobin)

Map<String, List<TopicPartition>> initialAssignment =

performInitialAssignment(partitionsPerTopic, subscriptions);

// 步骤2:优化分配,减少移动

Map<String, List<TopicPartition>> optimizedAssignment =

optimizeAssignment(initialAssignment,

getPreviousAssignment(subscriptions));

return optimizedAssignment;

}

// 优化算法:最小化分区移动

private Map<String, List<TopicPartition>> optimizeAssignment(

Map<String, List<TopicPartition>> current,

Map<String, List<TopicPartition>> previous) {

// 1. 计算每个消费者的目标分区数(均衡)

int totalPartitions = current.values().stream()

.mapToInt(List::size).sum();

int targetPerConsumer = totalPartitions / current.size();

// 2. 对于超额消费者,尝试将分区转移给不足的消费者

// 优先转移那些在previous中不属于当前消费者的分区

// 3. 使用启发式算法,最小化移动成本

return applyMinimalMovement(current, previous, targetPerConsumer);

}

}粘性分配示例

// 场景:重平衡前后对比

// 初始状态(消费者C3故障):

Consumer1: [A-0, A-1, B-0]

Consumer2: [A-2, B-1, B-2]

// C3恢复后,传统RoundRobin可能分配:

Consumer1: [A-0, B-1]

Consumer2: [A-1, B-2]

Consumer3: [A-2, B-0]

// 所有分区都移动了!

// StickyAssignor分配(保持粘性):

Consumer1: [A-0, B-0] // 保留A-0, B-0

Consumer2: [A-2, B-2] // 保留A-2, B-2

Consumer3: [A-1, B-1] // 只移动A-1, B-1

// 最小化移动,保留原有分配优缺点分析

优点:

- 分配均衡性好

- 重平衡时分区移动最小(粘性特性)

- 支持消费者订阅差异

- 减少重平衡开销

缺点:

- 算法复杂,计算成本较高

- 可能不是最优解(启发式算法)

- 需要维护历史分配状态

适用场景:

- 频繁重平衡的环境

- 消费者订阅主题不同的情况

- 需要最小化分区移动的敏感应用

- 消费者动态变化的场景

CooperativeStickyAssignor(协同粘性分配器)

Kafka 2.4+ 新特性

设计目标

关键改进:增量重平衡(Incremental Rebalance)

传统重平衡问题:

- Stop-the-world:所有消费者停止消费

- 重新分配所有分区

- 高延迟,影响可用性

增量重平衡优势:

- 只有受影响的分区重新分配

- 其他分区继续消费

- 多阶段完成,减少暂停时间

增量重平衡流程

配置与使用

// 启用协同粘性分配器

Properties props = new Properties();

props.put("partition.assignment.strategy",

"org.apache.kafka.clients.consumer.CooperativeStickyAssignor");

// 必须配置(消费者端)

props.put("max.poll.interval.ms", "300000"); // 适当延长

props.put("heartbeat.interval.ms", "3000");

props.put("session.timeout.ms", "45000");

// Broker端需要Kafka 2.4+

// 检查版本兼容性使用场景指南

class StrategySelectionGuide {

String selectStrategy(ConsumerScenario scenario) {

switch (scenario) {

case SIMPLE_SAME_TOPICS:

// 所有消费者订阅相同主题

// 要求严格均衡

return "RoundRobinAssignor";

case MIXED_SUBSCRIPTIONS:

// 消费者订阅不同主题

return "StickyAssignor";

case FREQUENT_REBALANCE:

// 频繁重平衡环境(如云环境)

// 需要最小化分区移动

return "CooperativeStickyAssignor";

case LEGACY_SYSTEM:

// 旧系统,Kafka版本低

// 需要简单稳定

return "RangeAssignor";

case ORDER_PROCESSING:

// 需要分区顺序处理

// 例如:按用户ID分区,相同用户消息顺序处理

return "RangeAssignor";

case HIGH_AVAILABILITY:

// 高可用要求,最小化重平衡影响

// Kafka 2.4+

return "CooperativeStickyAssignor";

default:

return "CooperativeStickyAssignor"; // 现代默认选择

}

}

}自定义分区策略

业务场景需求:

- 基于地理位置分配(就近消费)

- 基于硬件能力分配(高性能机器多消费)

- 基于业务优先级分配(重要业务专用消费者)

- 基于数据热点分配(热点数据分散)

- 混合分配策略(结合多种算法)

public class WeightedAssignor implements PartitionAssignor {

@Override

public String name() {

return "weighted";

}

@Override

public Subscription subscription(Set<String> topics) {

// 在订阅信息中包含权重

ByteBuffer userData = ByteBuffer.allocate(4);

userData.putInt(getConsumerWeight()); // 权重值

userData.flip();

return new Subscription(new ArrayList<>(topics), userData);

}

@Override

public Map<String, Assignment> assign(Cluster cluster,

Map<String, Subscription> subscriptions) {

// 1. 解析消费者权重

Map<String, Integer> weights = new HashMap<>();

int totalWeight = 0;

for (Map.Entry<String, Subscription> entry : subscriptions.entrySet()) {

int weight = parseWeight(entry.getValue().userData());

weights.put(entry.getKey(), weight);

totalWeight += weight;

}

// 2. 按权重分配分区

Map<String, List<TopicPartition>> assignment = new HashMap<>();

for (TopicPartition partition : allPartitions(cluster)) {

// 选择权重比例合适的消费者

String selectedConsumer = selectConsumerByWeight(partition, weights, totalWeight);

assignment.computeIfAbsent(selectedConsumer, k -> new ArrayList<>())

.add(partition);

}

return toAssignmentMap(assignment);

}

private int getConsumerWeight() {

// 根据硬件配置决定权重

int cores = Runtime.getRuntime().availableProcessors();

long memory = Runtime.getRuntime().maxMemory() / 1024 / 1024; // MB

// 简单权重计算:CPU核心数 + 内存(GB)

return cores + (int)(memory / 1024);

}

}配置自定义策略

// 使用自定义分配策略

Properties props = new Properties();

props.put("partition.assignment.strategy",

"com.company.WeightedAssignor,org.apache.kafka.clients.consumer.WeightedAssignor");

// 可以配置多个,按优先级回退

// 配置消费者权重信息

props.put("consumer.weight", "10"); // 自定义配置

// 确保所有消费者使用相同的策略列表!

// 否则会导致分配失败故障排查指南

常见问题1:分配不均衡

症状:

- 某些消费者负载高,某些空闲

- 消费延迟不均

可能原因:

- RangeAssignor的头部重问题

- 消费者订阅主题不同(RoundRobin)

- 分区数不能被消费者数整除

解决方案:

- 切换到StickyAssignor

- 调整分区数(如设为消费者数的倍数)

- 使用自定义权重策略

常见问题2:频繁重平衡

症状:

- 频繁的stop-the-world

- 消费暂停频繁

可能原因:

- 会话超时设置过短

- 处理时间超过max.poll.interval.ms

- 网络不稳定

解决方案:

- 使用CooperativeStickyAssignor(增量重平衡)

- 增加session.timeout.ms和max.poll.interval.ms

- 优化处理逻辑,减少单次处理时间

- 使用静态成员(group.instance.id)

常见问题3:分配策略冲突

症状:

- 消费者无法加入组

- 分配失败错误

可能原因:

- 消费者使用不同的分配策略

- 自定义策略版本不一致

- 策略配置错误

解决方案:

- 确保所有消费者配置相同的策略列表

- 检查策略类的类路径一致性

- 使用标准策略作为回退

- 验证策略实现的正确性

总和分析对比

| 特性 | RangeAssignor | RoundRobinAssignor | StickyAssignor | CooperativeStickyAssignor |

|---|---|---|---|---|

| 默认策略 | ✅ Kafka ≤ 2.3 | ❌ | ❌ | ✅ Kafka 2.4+ |

| 分配均衡性 | 一般(头部重) | 优秀(订阅相同时) | 优秀 | 优秀 |

| 分区连续性 | ✅ 保持连续 | ❌ 打散分布 | ❌ 可能打散 | ❌ 可能打散 |

| 订阅灵活性 | ✅ 支持不同订阅 | ❌ 要求相同订阅 | ✅ 支持不同订阅 | ✅ 支持不同订阅 |

| 重平衡开销 | 大(全部移动) | 大(全部移动) | 小(最小移动) | 最小(增量) |

| 计算复杂度 | 低 | 低 | 高 | 高 |

| Kafka版本 | 所有版本 | 所有版本 | 0.11+ | 2.4+ |

如何选择合适的分区策略

| 决策因素 | 推荐策略 | 理由 |

|---|---|---|

| 追求最小重平衡影响 | CooperativeStickyAssignor | 增量重平衡,暂停时间最短 |

| 消费者订阅不同主题 | StickyAssignor | 支持混合订阅,保持均衡 |

| Kafka版本 < 2.4 | StickyAssignor | 功能丰富,兼容性好 |

| 需要严格顺序处理 | RangeAssignor | 保持分区连续性 |

| 所有消费者订阅相同 | RoundRobinAssignor | 分配最均衡 |

| 特殊业务需求 | 自定义策略 | 灵活满足特定需求 |

Kafka重平衡(Rebalance)原理

什么是Kafka重平衡(Rebalance)

重平衡是Kafka消费者组的核心机制;

定义:当消费者组成员发生变化时,Kafka重新分配分区给各个消费者的过程;

本质:分布式系统中的动态负载均衡机制;

目的:确保每个分区有且只有一个消费者在消费

触发:消费者组的成员变化

为什么要做重平衡(Rebalance)

根本原因:保证Kafka消费语义的核心约束"每个分区在任何时刻只能被同一个消费者组中的一个消费者消费";

具体原因分析:

避免重复消费(正确性) 没有重平衡 → 多个消费者可能消费同一分区 → 消息重复

避免消息丢失(完整性) 消费者故障时,其分区无人消费 → 消息积压

负载均衡(公平性) 消费者能力不同或分区负载不均 → 需要重新分配

动态伸缩(弹性) 业务变化需要增减消费者 → 系统需要自适应

故障恢复(可用性) 消费者故障 → 需要将分区重新分配给健康消费者

触发重平衡的场景

- 消费者加入或离开

- 加入:新消费者启动,扩容

- 离开:消费者关闭,缩容,故障

- 消费者配置变化

- 订阅主题变化

- 分配策略变化

- 会话超时配置变化

- 主题分区变化

- 分区数增加或减少

- 主题被删除或创建

- 心跳超时

- session.timeout.ms内未收到心跳

- 可能:消费者卡住、GC停顿、网络问题,消费者Full GC导致心跳超时;

- Poll间隔超时

- max.poll.interval.ms内未调用poll()

- 可能:消息处理时间过长,单条消息处理耗时超过5分钟;

如果没有重平衡,可能会发生某一个分区消息没有消费者消费导致消息丢失;

重平衡的完整流程

传统重平衡流程(Eager Rebalance)

步骤1:检测与触发

class RebalanceDetection {

// GroupCoordinator检测重平衡条件

class GroupCoordinator {

void checkRebalanceConditions() {

// 检测逻辑

if (newConsumerJoined()) {

triggerRebalance("新消费者加入");

}

if (consumerTimedOut(memberId)) {

triggerRebalance("消费者心跳超时");

}

if (subscriptionChanged()) {

triggerRebalance("订阅变化");

}

if (metadataChanged()) {

triggerRebalance("元数据变化");

}

}

void triggerRebalance(String reason) {

log.info("触发重平衡,原因: {}", reason);

// 1. 增加generationId(防止脑裂)

group.generationId++;

// 2. 标记组状态

group.transitionTo(GroupState.PREPARING_REBALANCE);

// 3. 通知所有消费者

notifyConsumersForRebalance();

}

}

}步骤2:消费者暂停与准备

class ConsumerPreparation {

// 消费者收到重平衡通知后的处理

class ConsumerCoordinator {

void onRebalanceTriggered() {

// 1. 调用重平衡监听器的onPartitionsRevoked

if (rebalanceListener != null) {

rebalanceListener.onPartitionsRevoked(assignedPartitions);

}

// 2. 提交偏移量(如果启用)

if (autoCommitEnabled) {

commitOffsetsSync();

}

// 3. 停止消费当前分区

fetcher.pause(); // 暂停拉取

clearBufferedRecords(); // 清空缓冲

// 4. 重置分配状态

subscriptions.unsubscribe();

// 5. 重新加入组

needRejoin = true;

}

}

}步骤3:JoinGroup阶段

class JoinGroupPhase {

// JoinGroup协议的详细处理

class GroupCoordinator {

def handleJoinGroup(request: JoinGroupRequest): JoinGroupResponse = {

val group = getOrCreateGroup(request.groupId);

// 1. 收集成员信息

group.addMember(request.memberId, request.metadata);

// 2. 等待所有成员加入(或超时)

val timeout = group.rebalanceTimeoutMs;

val deadline = System.currentTimeMillis() + timeout;

while (!group.hasReceivedJoinFromAllMembers &&

System.currentTimeMillis() < deadline) {

Thread.sleep(100);

}

// 3. 选举Leader

val leaderId = electLeader(group);

// 4. 构建响应

return JoinGroupResponse(

error = Errors.NONE,

generationId = group.generationId,

leaderId = leaderId,

memberId = request.memberId,

members = if (request.memberId == leaderId)

group.allMembers else List.empty

);

}

// 确定性Leader选举算法

def electLeader(group: GroupMetadata): String = {

// 按memberId字典序排序,选择第一个

val sortedMembers = group.allMembers

.sortBy(member => member.memberId);

return sortedMembers.head.memberId;

}

}

}步骤4:SyncGroup阶段

class SyncGroupPhase {

// Leader消费者的分配计算

class LeaderConsumer {

void performAssignment() {

// 1. 收集所有成员订阅信息(只有Leader能收到)

Map<String, Subscription> allSubscriptions =

joinResponse.members;

// 2. 运行分配策略

PartitionAssignor assignor = getAssignor();

Map<String, Assignment> assignments =

assignor.assign(clusterMetadata, allSubscriptions);

// 3. 序列化分配结果

Map<String, byte[]> assignmentBytes = new HashMap<>();

for (Map.Entry<String, Assignment> entry : assignments.entrySet()) {

assignmentBytes.put(entry.getKey(),

entry.getValue().serialize());

}

// 4. 发送给GroupCoordinator

sendSyncGroupRequest(assignmentBytes);

}

}

// GroupCoordinator分发分配结果

class GroupCoordinator {

def handleSyncGroup(request: SyncGroupRequest): SyncGroupResponse = {

// 如果是Leader,保存分配方案

if (request.memberId == group.leaderId) {

group.assignment = request.groupAssignment;

}

// 返回给每个消费者其分配结果

val memberAssignment = group.assignment

.getOrDefault(request.memberId, Array.emptyByteArray);

return SyncGroupResponse(

error = Errors.NONE,

assignment = memberAssignment

);

}

}

}步骤5:恢复消费

class ResumeConsumption {

class ConsumerCoordinator {

void onSyncGroupComplete(byte[] assignmentData) {

// 1. 解析分配结果

Assignment assignment = deserializeAssignment(assignmentData);

// 2. 更新订阅状态

subscriptions.assignFromSubscribed(assignment.partitions());

// 3. 查找偏移量

for (TopicPartition partition : assignment.partitions()) {

long offset = fetchCommittedOffset(partition);

if (offset >= 0) {

consumer.seek(partition, offset);

} else {

// 使用auto.offset.reset策略

resetToDefaultOffset(partition);

}

}

// 4. 调用重平衡监听器的onPartitionsAssigned

if (rebalanceListener != null) {

rebalanceListener.onPartitionsAssigned(assignment.partitions());

}

// 5. 恢复拉取消息

fetcher.resume();

// 6. 开始心跳

heartbeatThread.enable();

}

}

}增量重平衡流程(Cooperative Rebalance)

// Kafka 2.4+ 引入的增量重平衡

class IncrementalRebalance {

/*

传统重平衡问题:

1. Stop-the-world:所有消费者都停止消费

2. 所有分区重新分配,即使大多数没变化

3. 高延迟,影响业务连续性

增量重平衡改进:

1. 分阶段进行,减少停顿时间

2. 只重新分配必要的分区

3. 支持平滑过渡

*/

}增量虫平衡过程

重平衡的成本分析

class RebalanceCostAnalysis {

/*

重平衡的代价:

1. 消费停顿(Stop-the-world)

- 所有消费者停止处理消息

- 持续时间:从几秒到几分钟

- 影响:业务延迟增加,吞吐量下降

2. 重复消费风险

- 如果偏移量提交在重平衡后

- 可能重新消费已处理的消息

- 需要幂等消费处理

3. 状态重建开销

- 消费者需要重新初始化状态

- 连接重建,缓存预热

- 对于有状态处理(如聚合)代价高

4. 网络和CPU开销

- JoinGroup/SyncGroup请求

- 分配计算开销

- 心跳同步

*/

// 示例:电商订单处理系统

void ecommerceExample() {

// 重平衡前:处理1000订单/秒

// 重平衡期间:暂停10秒 → 少处理10000订单

// 恢复后:需要几分钟回到峰值

// 大促期间可能造成订单积压

}

}配置优化

class RebalanceConfigOptimization {

Properties getOptimizedConfig() {

Properties props = new Properties();

// 1. 合理设置会话超时(平衡检测速度和误判)

// 太小:网络抖动导致误重平衡

// 太大:故障检测慢

props.put("session.timeout.ms", "30000"); // 30秒

props.put("heartbeat.interval.ms", "3000"); // 3秒

// 2. 合理设置poll间隔

props.put("max.poll.interval.ms", "300000"); // 5分钟

props.put("max.poll.records", "500"); // 控制处理时间

// 3. 使用增量重平衡(Kafka 2.4+)

props.put("partition.assignment.strategy",

"org.apache.kafka.clients.consumer.CooperativeStickyAssignor");

// 4. 启用静态成员(避免不必要的重平衡)

props.put("group.instance.id", "consumer-" + getInstanceId());

// 5. 调整重平衡超时

props.put("rebalance.timeout.ms", "60000"); // 60秒

return props;

}

}架构优化设计

class ArchitectureOptimization {

// 1. 消费者组设计

void designConsumerGroups() {

// 原则:按业务功能分组,减少相互影响

// 订单组、日志组、监控组分开

// 避免大消费者组(>100消费者)

// 可考虑拆分为多个小组

}

// 2. 分区数设计

void designPartitionCount() {

// 分区数 = 消费者数 × N(N=2-3)

// 预留扩容空间,避免频繁增加分区

// 示例:10个消费者 → 20-30个分区

// 这样增加消费者时不需要增加分区

}

// 3. 主题设计

void designTopics() {

// 热点主题单独分组

// 低频主题合并分组

// 使用正则订阅时注意范围

// 避免订阅.*导致不必要的重平衡

}

}去我呢提排查即优化

class TypicalProblems {

// 案例1:消费者处理消息时间过长

void case1_longProcessingTime() {

/*

现象:

- 频繁出现"poll timeout"重平衡

- 消费者日志显示消息处理耗时

原因:

- max.poll.records设置过大

- 单条消息处理逻辑复杂

- 同步调用外部服务

解决方案:

1. 减少max.poll.records

2. 异步处理耗时操作

3. 增加max.poll.interval.ms

4. 优化处理逻辑

*/

}

// 案例2:网络不稳定导致心跳超时

void case2_networkInstability() {

/*

现象:

- 随机的心跳失败

- 消费者频繁重新加入

- 网络监控显示丢包

原因:

- 网络抖动或分区

- 防火墙规则问题

- 负载均衡器配置

解决方案:

1. 增加session.timeout.ms

2. 优化网络配置

3. 使用静态成员减少影响

4. 监控网络质量

*/

}

// 案例3:Coordinator负载过高

void case3_coordinatorOverload() {

/*

现象:

- 多个消费者组同时重平衡

- Coordinator节点CPU高

- 重平衡响应慢

原因:

- 消费者组过多集中在一个Coordinator

- Coordinator资源不足

- 大消费者组计算复杂

解决方案:

1. 调整__consumer_offsets分区分布

2. 升级Coordinator节点配置

3. 优化分配策略复杂度

4. 分散消费者组

*/

}

}核心要点回顾

- 重平衡是什么:

- Kafka消费者组的动态负载均衡机制

- 确保每个分区有且只有一个消费者消费

- 消费者组成员变化时的必要调整过程

- 为什么需要重平衡:

- 保证消息消费的正确性(避免重复/丢失)

- 实现负载均衡和故障恢复

- 支持系统的弹性伸缩

- 重平衡流程:

- 传统重平衡:Stop-the-world,所有分区重新分配

- 增量重平衡(Kafka 2.4+):平滑过渡,最小中断

- 关键阶段:检测→暂停→加入→分配→恢复

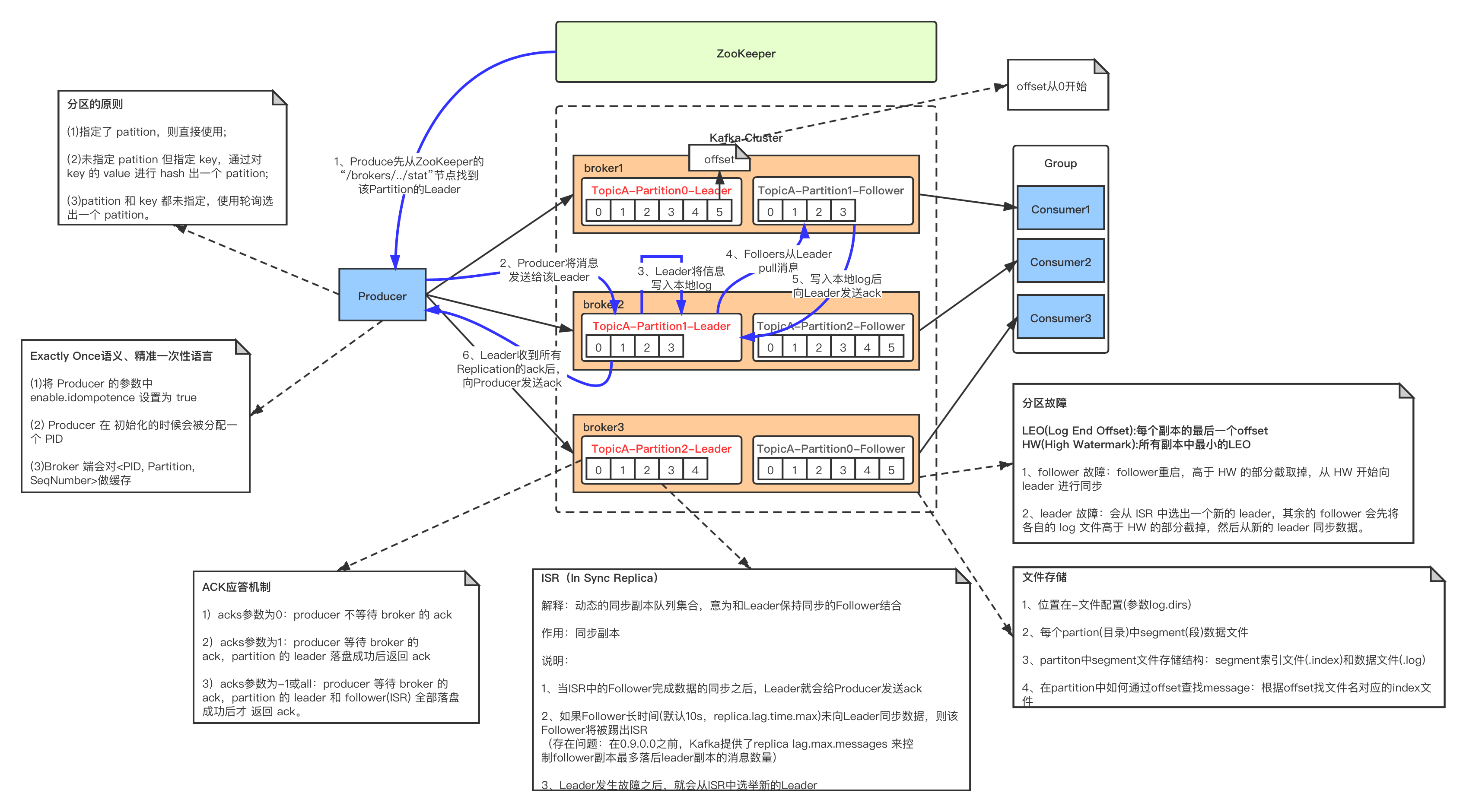

Kafka 的设计架构?

简单的设计架构

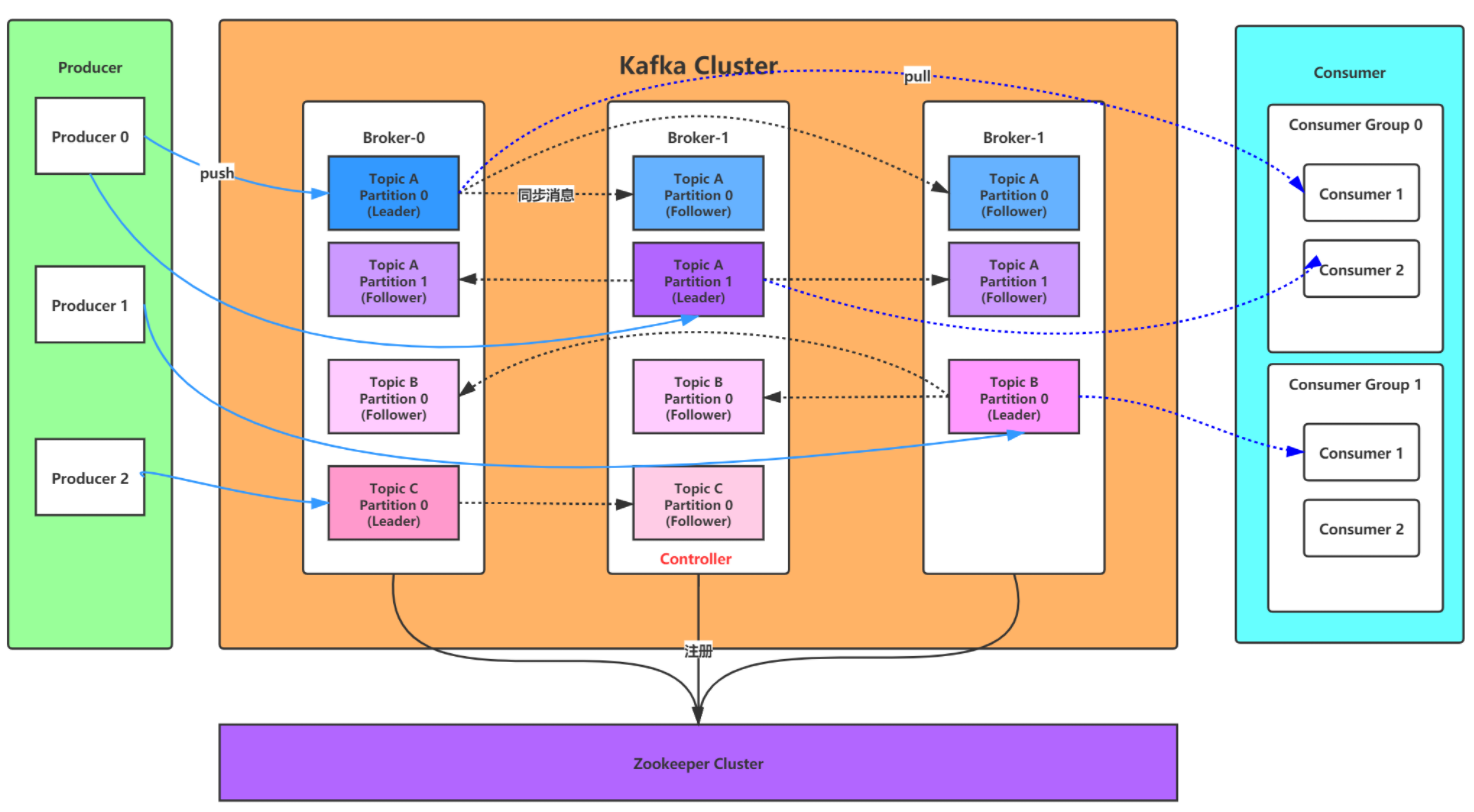

Kafak 总体架构图中包含多个概念:

(1)ZooKeeper:Zookeeper 负责保存 broker 集群元数据,并对控制器进行选举等操作。

(2)Producer:生产者负责创建消息,将消息发送到 Broker。

(3)Broker: 一个独立的 Kafka 服务器被称作 broker,broker 负责接收来自生产者的消息,为消息设置偏移量,并将消息存储在磁盘。broker 为消费者提供服务,对读取分区的请求作出响应,返回已经提交到磁盘上的消息。

(4)Consumer:消费者负责从 Broker 订阅并消费消息。

(5)Consumer Group:Consumer Group 为消费者组,一个消费者组可以包含一个或多个 Consumer 。

使用 多分区 + 多消费者 方式可以极大 提高数据下游的处理速度,

同一消费者组中的消费者不会重复消费消息,同样的,不同消费组中的消费者消费消息时互不影响。Kafka 就是通过消费者组的方式来实现消息 P2P 模式和广播模式。

(6)Topic:Kafka 中的消息 以 Topic 为单位进行划分,生产者将消息发送到特定的 Topic,而消费者负责订阅 Topic 的消息并进行消费。

(7)Partition:一个 Topic 可以细分为多个分区,每个分区只属于单个主题。同一个主题下不同分区包含的消息是不同的,分区在存储层面可以看作一个可追加的 日志(Log)文件,消息在被追加到分区日志文件的时候都会分配一个特定的 偏移量(offset)。

(8)Offset:offset 是消息在分区中的唯一标识,Kafka 通过它来保证消息在分区内的顺序性,不过 offset 并不跨越分区,也就是说,Kafka保证的是分区有序性而不是主题有序性。

(9)Replication:副本,是 Kafka 保证数据高可用的方式,Kafka 同一 Partition 的数据可以在多 Broker 上存在多个副本,通常只有主副本对外提供读写服务,当主副本所在 broker 崩溃或发生网络异常,Kafka 会在 Controller 的管理下会重新选择新的 Leader 副本对外提供读写服务。

(10)Record:实际写入 Kafka 中并可以被读取的消息记录。每个 record 包含了key、value 和 timestamp。

(11)Leader: 每个分区多个副本的 "主" leader,生产者发送数据的对象,以及消费者消费数据的对象都是 leader。

(12)follower: 每个分区多个副本中的"从" follower,实时从 Leader 中同步数据,保持和 leader 数据的同步。Leader 发生故障时,某个 follow 会成为新的 leader。

介绍一下零拷贝技术

写数据到磁盘

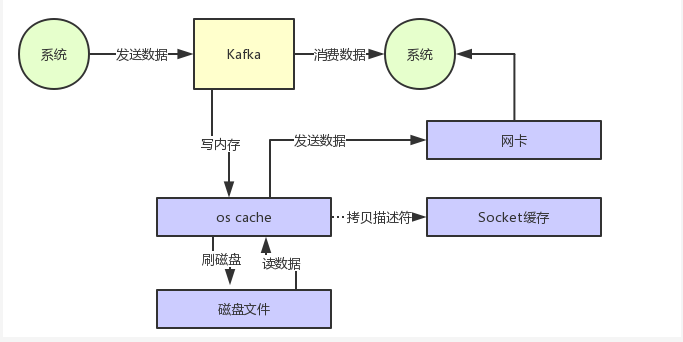

从 Kafka 里经常要消费数据,那么消费的时候实际上就是要从 kafka 的磁盘文件里读取某条数据然后发送给下游的消费者,如下图所示。

应用程序读取数据

那么这里如果频繁的从磁盘读数据然后发给消费者,会增加两次没必要的拷贝,如下图:

一次是从操作系统的 cache 里拷贝到应用进程的缓存里,接着又从应用程序缓存里拷贝回操作系统的 Socket 缓存里。

而且为了进行这两次拷贝,中间还发生了好几次上下文切换,一会儿是应用程序在执行,一会儿上下文切换到操作系统来执行。所以这种方式来读取数据是比较消耗性能的。

Kafka 为了解决这个问题,在读数据的时候是引入零拷贝技术。

零拷贝技术介绍

也就是说,直接让操作系统的 cache 中的数据发送到网卡后传输给下游的消费者,中间跳过了两次拷贝数据的步骤,Socket 缓存中仅仅会拷贝一个描述符过去,不会拷贝数据到 Socket 缓存,如下图所示:

通过 零拷贝技术,就不需要把 os cache 里的数据拷贝到应用缓存,再从应用缓存拷贝到 Socket 缓存了,两次拷贝都省略了,所以叫做零拷贝。

对 Socket 缓存仅仅就是拷贝数据的描述符过去,然后数据就直接从 os cache 中发送到网卡上去了,这个过程大大的提升了数据消费时读取文件数据的性能。

Kafka 从磁盘读数据的时候,会先看看 os cache 内存中是否有,如果有的话,其实读数据都是直接读内存的。

kafka 集群经过良好的调优,数据直接写入 os cache 中,然后读数据的时候也是从 os cache 中读。相当于 Kafka 完全基于内存提供数据的写和读了,所以这个整体性能会极其的高。

传统IO流程:

第一次:将磁盘文件,读取到操作系统内核缓冲区。

第二次:将内核缓冲区的数据,copy到application应用程序的buffer。

第三步:将application应用程序buffer中的数据,copy到socket网络发送缓冲区(属于操作系统内核的缓冲区)

第四次:将socket buffer的数据,copy到网卡,由网卡进行网络传输。

传统方式,读取磁盘文件并进行网络发送,经过的四次数据copy是非常繁琐的。实际IO读写,需要进行IO中断,需要CPU响应中断(带来上下文切换),尽管后来引入DMA来接管CPU的中断请求,但四次copy是存在“不必要的拷贝”的。

重新思考传统IO方式,会注意到实际上并不需要第二个和第三个数据副本。应用程序除了缓存数据并将其传输回套接字缓冲区之外什么都不做。相反,数据可以直接从读缓冲区传输到套接字缓冲区。

显然,第二次和第三次数据copy 其实在这种场景下没有什么帮助反而带来开销,这也正是零拷贝出现的意义。

所以零拷贝是指读取磁盘文件后,不需要做其他处理,直接用网络发送出去。

流程说明

传统方式:读取文件并发送到网络; 数据流向(4次拷贝 + 4次上下文切换);

磁盘文件 → 内核缓冲区 → 用户缓冲区 → Socket缓冲区 → 网卡;

详细步骤:

read() 系统调用:

- 用户态 → 内核态(上下文切换1)

- DMA从磁盘拷贝到内核缓冲区(拷贝1)

- 内核缓冲区拷贝到用户缓冲区(拷贝2)

- 内核态 → 用户态(上下文切换2)

write() 系统调用:

- 用户态 → 内核态(上下文切换3)

- 用户缓冲区拷贝到Socket缓冲区(拷贝3)

- 内核态 → 用户态(上下文切换4)

网络传输:

- DMA从Socket缓冲区拷贝到网卡(拷贝4)

总开销:4次拷贝 + 4次上下文切换 问题:多次不必要的数据复制和上下文切换

零拷贝技术实现

零拷贝(Zero-Copy):

- 核心思想:减少数据在内存中的拷贝次数

- 目标:数据直接从内核缓冲区传输到目标缓冲区,跳过用户空间

- 实现:利用操作系统提供的特殊系统调用

技术本质:不是真的"零次拷贝",而是:

- 减少不必要的拷贝次数(从4次到2次)

- 消除用户空间和内核空间之间的数据拷贝

- 减少CPU参与的数据复制操作

关键技术:

- mmap(内存映射)

- sendfile(Linux系统调用)

- DMA(直接内存访问)

实现过程:

简单的来说,比如用户读取一个文件,那么首先文件会读取到内存的缓冲区,然后在从缓冲区通过网络将数据发送给用户。可以抽象为下面两部:

read(file, tmp_buf, len);

write(socket, tmp_buf, len);但是实际上,中间经历了四个过程,因为读取文件需要在用户态和和心态之间相互转换:

- 程序调用 read 产生一次用户态到内核态的上下文切换。DMA 模块从磁盘读取文件内容,将其拷贝到内核空间的缓冲区,完成第 1 次拷贝。

- 数据从内核缓冲区拷贝到用户空间缓冲区,之后系统调用 read 返回,这回导致从内核空间到用户空间的上下文切换。这个时候数据存储在用户空间的 tmp_buf 缓冲区内,可以后续的操作了。

- 程序调用 write 产生一次用户态到内核态的上下文切换。数据从用户空间缓冲区被拷贝到内核空间缓冲区,完成第 3 次拷贝。但是这次数据存储在一个和 socket 相关的缓冲区中,而不是第一步的缓冲区。

- write 调用返回,产生第 4 个上下文切换。第 4 次拷贝在 DMA 模块将数据从内核空间缓冲区传递至协议引擎的时候发生,这与我们的代码的执行是独立且异步发生的。你可能会疑惑:“为何要说是独立、异步?难道不是在 write 系统调用返回前数据已经被传送了?write 系统调用的返回,并不意味着传输成功——它甚至无法保证传输的开始。调用的返回,只是表明以太网驱动程序在其传输队列中有空位,并已经接受我们的数据用于传输。可能有众多的数据排在我们的数据之前。除非驱动程序或硬件采用优先级队列的方法,各组数据是依照FIFO的次序被传输的(上图中叉状的 DMA copy 表明这最后一次拷贝可以被延后)。

mmap(内存映射文件)

mmap(Memory Map): 将文件直接映射到进程的地址空间

工作流程:

mmap() 系统调用:

- 建立文件到虚拟内存的映射关系

- 并不立即加载文件内容

访问数据时(缺页中断):

- DMA将磁盘数据直接加载到内核缓冲区

- 内核缓冲区映射到用户空间虚拟地址

操作数据:

- 直接通过内存指针访问文件数据

- 写操作时,数据先到内核缓冲区,异步刷盘

优势:

- 避免用户空间和内核空间的数据拷贝

- 大文件处理效率高

- 多个进程可以共享同一文件映射

限制:

- 32位系统地址空间有限(通常1.5-2GB用户空间)

- 文件过大时可能内存不足

- 频繁的小文件映射开销大

sendfile系统调用

sendfile() 系统调用: 专门用于文件到Socket的直接传输

工作流程(Linux 2.4+):

sendfile() 调用:

- 用户态 → 内核态(上下文切换1)

DMA拷贝:

- DMA将文件数据从磁盘拷贝到内核缓冲区(拷贝1)

DMA Gather Copy:

- DMA直接从内核缓冲区拷贝到网卡(拷贝2)

- 使用DMA Gather技术,支持不连续缓冲区

完成:

- 内核态 → 用户态(上下文切换2)

总开销:2次拷贝 + 2次上下文切换 相比传统:减少50%的拷贝和上下文切换

版本演进:

- Linux 2.1: 引入sendfile,但需要CPU参与一次拷贝

- Linux 2.4: 支持DMA Gather,实现真正的零拷贝

拷贝方式对比

| 特性 | 传统read/write | mmap | sendfile |

|---|---|---|---|

| 拷贝次数 | 4次 | 3次 | 2次 |

| 上下文切换 | 4次 | 4次 | 2次 |

| CPU参与 | 高 | 中 | 低 |

| 内存使用 | 需要用户缓冲区 | 虚拟地址映射 | 无需额外缓冲 |

| 适用场景 | 小文件,简单场景 | 随机访问大文件 | 文件网络传输 |

| 系统要求 | 所有系统 | 需要mmap支持 | Linux 2.4+ |

| 数据修改 | 容易 | 支持 | 不支持 |

零拷贝技术在kafka中的应用

Kafka的数据流架构

Kafka完整数据路径: 生产者 → Broker磁盘 → Broker内存 → 消费者

关键优化点:

- 生产者到Broker:批处理压缩

- Broker磁盘:顺序写 + PageCache

- Broker到消费者:零拷贝读取

消费者数据读取路径: 磁盘 → PageCache → Socket → 网络 → 消费者

Kafka的优化组合:

- 顺序I/O:最大化磁盘吞吐

- PageCache:利用操作系统缓存

- 零拷贝:减少CPU开销

- 批处理:减少网络往返

kafka生产端优化

生产者端的优化(虽然不是零拷贝,但相关):

批处理:

- 多个消息合并为一个批次

- 减少网络请求次数

压缩:

- 在生产者端压缩数据

- 减少网络传输量

- 在Broker和消费者端解压

配合零拷贝的效果: 生产者(压缩批处理) → 网络传输减少 → Broker(零拷贝存储) → 消费者(零拷贝读取 + 解压)

端到端优化链: 压缩 → 批处理 → 顺序写 → PageCache → 零拷贝读

Kafka存储层的优化

Kafka日志存储的零拷贝优化

- 内存映射文件(mmap);

- 顺序写优化

- Kafka的写入优化:

- 只追加写(append-only)

- 批量刷盘

- 利用PageCache

- 优势:

- 机械硬盘顺序写比随机写快100倍

- 减少磁盘寻道时间

- 配合零拷贝读取达到最佳性能

- Kafka的写入优化:

- PageCache利用,Kafka与PageCache的协同:

读取路径:

- 消费者请求数据

- 检查PageCache是否命中

- 命中:直接从内存发送(零拷贝)

- 未命中:从磁盘读取到PageCache,然后发送

写入路径:

- 生产者数据到达

- 写入PageCache

- 异步刷盘到磁盘

- 后续读取直接从PageCache

优势:

- 热数据在内存中

- 冷数据在磁盘

- 自动缓存管理

小结(Kafka零拷贝架构优势)

端到端优化链:

生产者(压缩+批处理)

→ 网络传输(减少数据量)

→ Broker(顺序写+PageCache)

→ 消费者拉取(零拷贝)

→ 消费者(批量处理)

关键技术组合:

1. 顺序I/O:最大化磁盘吞吐

2. PageCache:利用操作系统缓存

3. 零拷贝:减少CPU开销

4. 批处理:减少系统调用

5. 压缩:减少网络传输高性能高吞吐的技术实现

页缓存技术

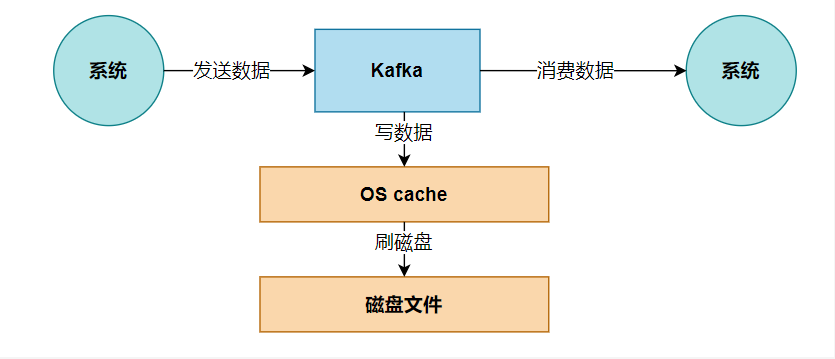

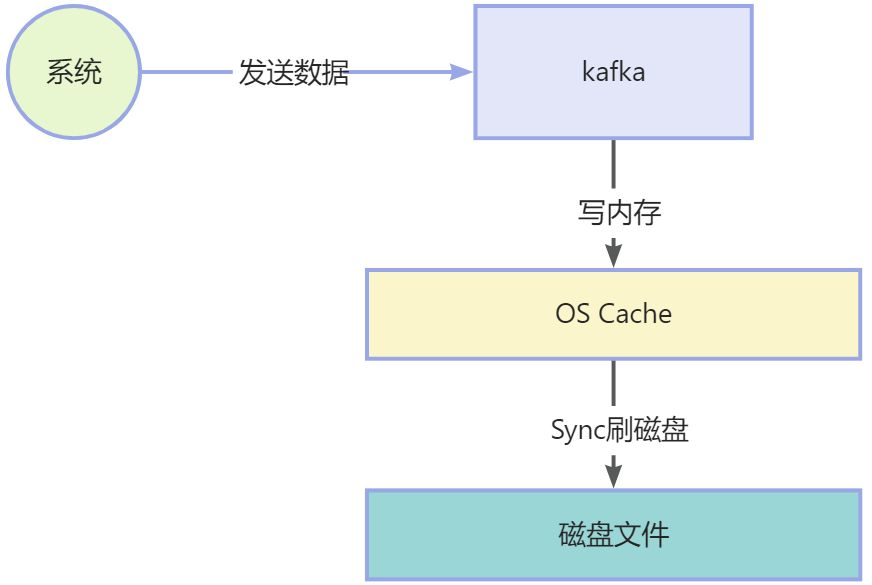

Kafka 是基于 操作系统 的页缓存来实现文件写入的。

操作系统本身有一层缓存,叫做 page cache,是在 内存里的缓存,我们也可以称之为 os cache,意思就是操作系统自己管理的缓存。

Kafka 在写入磁盘文件的时候,可以直接写入这个 os cache 里,也就是仅仅写入内存中,接下来由操作系统自己决定什么时候把 os cache 里的数据真的刷入磁盘文件中。通过这一个步骤,就可以将磁盘文件写性能提升很多了,因为其实这里相当于是在写内存,不是在写磁盘,原理图如下:

磁盘顺序I/O

另一个主要功能是 kafka 写数据的时候,是以磁盘顺序写的方式来写的。也就是说,仅仅将数据追加到文件的末尾,不是在文件的随机位置来修改数据。

kafka底层数据文件的存储结构

// Kafka的日志结构示意

partition-0/

├── 00000000000000000000.log // 消息数据文件

├── 00000000000000000000.index // 稀疏索引文件

├── 00000000000000000000.timeindex

└── 00000000000000001024.log // 下一个日志段kafka写入磁盘的操作顺序:

- 顺序追加到当前活跃的日志段.

- 只写入操作系统页缓存,异步刷盘

- 调用操作系统: write(fd, buffer, size)

- 数据先进入Page Cache,由OS决定何时刷到磁盘

- 更新索引(稀疏索引,不是每条消息都建索引)

普通的机械磁盘如果你要是随机写的话,确实性能极差,也就是随便找到文件的某个位置来写数据。

但是如果你是 追加文件末尾 按照顺序的方式来写数据的话,那么这种磁盘顺序写的性能基本上可以跟写内存的性能相差无几。

随机io和数序io的效率对比:

传统随机写 vs Kafka顺序写:

┌─────────────────┬────────────────────────────┬─────────────────────────┐

│ 维度 │ 传统数据库/消息队列 │ Kafka │

├─────────────────┼────────────────────────────┼─────────────────────────┤

│ 磁盘寻址 │ 频繁随机寻址(10ms/次) │ 顺序追加(几乎无寻址) │

│ 写入模式 │ 覆盖写/更新写 │ 只追加(append-only) │

│ I/O效率 │ 低(100-200 IOPS) │ 高(5000+ IOPS) │

│ 机械硬盘吞吐 │ 2-5 MB/s │ 50-100 MB/s │

│ SSD吞吐 │ 20-50 MB/s │ 200-500 MB/s │

└─────────────────┴────────────────────────────┴─────────────────────────┘基于上面两点,kafka 就实现了写入数据的超高性能。

为什么可以这样做,因为kafka每一个分区内部的数据是有序的,落盘后也是有序的,因此可以顺序写从盘;

Kafka利用页缓存的关键:

写入时:数据先写入Page Cache(内存)

读取时:优先从Page Cache读取

刷盘策略:由OS内核线程(pdflush/kworker)异步刷盘

预读机制:readahead预读后续数据到缓存

内核调用路径:

生产者写入:write() → VFS → Page Cache → 标记dirty

消费者读取:read() → 检查Page Cache命中 → 返回数据

批量处理(Batching)优化原理

批处理是一种常用的用于提高I/O性能的方式. 对Kafka而言, 批处理既减少了网络传输的Overhead, 又提高了写磁盘的效率. Kafka 0.82 之后是将多个消息合并之后再发送, 而并不是send一条就立马发送(之前支持)

生产者批量发送

- 收集批次;

- 压缩批次(如果配置)

- 发送批次

关键配置参数:

- batch.size: 批次大小阈值 (默认16KB)

- linger.ms: 等待时间阈值 (默认0ms)

- buffer.memory: 总缓冲区大小 (默认32MB)

- compression.type: 压缩类型

数据压缩

数据压缩的一个基本原理是, 重复数据越多压缩效果越好. 因此将整个Batch的数据一起压缩能更大幅度减小数据量, 从而更大程度提高网络传输效率。

Broker接收消息后,并不直接解压缩,而是直接将消息以压缩后的形式持久化到磁盘, Consumer接受到压缩后的数据再解压缩,

整体来讲: Producer 到 Broker, 副本复制, Broker 到 Consumer 的数据都是压缩后的数据, 保证高效率的传输

压缩性能对比

压缩算法选择策略:

┌─────────────┬──────────┬──────────┬──────────┬────────────┐

│ 算法 │ 压缩率 │ 压缩速度 │ 解压速度 │ 适用场景 │

├─────────────┼──────────┼──────────┼──────────┼────────────┤

│ none │ 1.0x │ 最快 │ 最快 │ 网络带宽充足│

│ gzip │ 3-5x │ 慢 │ 中等 │ 历史数据存储│

│ snappy │ 1.5-2x │ 快 │ 很快 │ 实时流处理 │

│ lz4 │ 2-3x │ 非常快 │ 极快 │ 低延迟场景 │

│ zstd │ 3-5x │ 中等 │ 快 │ 平衡型场景 │

└─────────────┴──────────┴──────────┴──────────┴────────────┘

Kafka压缩特点:

1. 端到端压缩:生产者压缩 → Broker存储压缩 → 消费者解压

2. 批次压缩:整个批次压缩,比单条消息压缩率高

3. 零拷贝解压:消费者拉取时不解压,直接传输压缩数据- GZIP:DEFLATE算法,高压缩比 ,适合冷数据,CPU消耗高

- Snappy:Google开发,速度快,不追求最高压缩比,适合实时数据

- LZ4:速度极快,压缩比合理,适合追求低延迟的场景

- ZSTD:Facebook开发,平衡型,支持多压缩级别,可调压缩比/速度

零拷贝技术

传统文件发送过程:

- DMA将磁盘数据拷贝到内核缓冲区(磁盘 → 内核缓冲区,DMA拷贝)

- CPU将内核缓冲区数据拷贝到用户缓冲区(内核态 → 用户态,CPU拷贝)

- CPU将用户缓冲区数据拷贝到Socket缓冲区(用户态 → 内核态,CPU拷贝)

- DMA将Socket缓冲区数据拷贝到网卡(内核缓冲区 → 网卡,DMA拷贝)

总成本:4次拷贝 + 4次上下文切换

Kafka的零拷贝实现(2次拷贝 + 2次上下文切换)

底层调用Linux的sendfile系统调用sendfile(out_fd, in_fd, offset, count)

流程:

- DMA将文件数据从磁盘拷贝到内核缓冲区

- 内核直接将内核缓冲区数据拷贝到网卡缓冲区

- DMA将数据从网卡缓冲区发送到网络

跳过了用户空间的拷贝!

分区并行架构原理

分区负载均衡机制

Producer分区选择策略:

1. 轮询(Round Robin): 均匀分布到所有分区

partition = (counter++) % numPartitions

2. 键哈希(Key Hashing): 相同key到同一分区

partition = murmur2(key) % numPartitions

3. 粘性分区(Sticky Partitioning): Kafka 2.4+

- 批次内消息尽量发到同一分区

- 批次满后切换到下一个分区

消费者负载均衡:

┌─────────────────────────────────────────────┐

│ Consumer Group: "my-group" │

│ Topic: "orders" Partitions: 0,1,2,3 │

├─────────────────────────────────────────────┤

│ Consumer C1: partitions [0, 1] │

│ Consumer C2: partitions [2, 3] │

│ │

│ 再均衡触发条件: │

│ 1. 消费者加入/离开 │

│ 2. 分区数变化 │

│ 3. 心跳超时( session.timeout.ms ) │

│ 4. 拉取超时( max.poll.interval.ms ) │

└─────────────────────────────────────────────┘消费者端触发重平衡后,可以很方便的对下游消费者进行扩容缩容,做到高效消费数据;

稀疏索引机制

索引文件结构:

偏移量 → 物理位置映射(每4KB数据建一个索引)

示例:

┌─────────────────┬─────────────────┐

│ 相对偏移(4字节) │ 物理位置(4字节) │

├─────────────────┼─────────────────┤

│ 0 │ 0 │ # 第一条消息

│ 103 │ 4096 │ # 第104条消息,位于4KB处

│ 217 │ 8192 │ # 第218条消息,位于8KB处

│ 331 │ 12288 │ # 第332条消息,位于12KB处

└─────────────────┴─────────────────┘

查找算法:

1. 目标偏移:寻找偏移350的消息

2. 二分查找:找到 ≤350的最大索引条目(偏移331)

3. 扫描查找:从位置12288开始顺序扫描,找到偏移350

4. 时间复杂度:O(log N) + O(M),N=索引条目数,M=扫描条数

索引维护:

- 每个日志段对应一个索引文件

- 索引文件大小固定,避免无限增长

- 索引文件与日志文件一起清理拉取模式(Pull-based)优势

class Fetcher {

private final ConsumerNetworkClient client;

public FetchResult fetch(FetchRequest request) {

// 拉取模式优点:

// 1. 消费者控制消费速率(背压机制)

// 2. 批量拉取,减少网络往返

// 3. 支持长轮询,Broker无数据时等待

// 关键配置:

// fetch.min.bytes: 最小拉取字节数(默认1)

// fetch.max.wait.ms: 最长等待时间(默认500)

// max.partition.fetch.bytes: 每个分区最大字节数

// 长轮询实现:

while (true) {

FetchResult result = client.send(request);

if (result.hasData() || timeoutReached()) {

return result;

}

// 无数据,等待一段时间再检查

wait(pollInterval);

}

}

}最关键的一点,基于消费者pull模式,不用考虑消费者控制消费速率(背压机制),控制权在消费者。

偏移量管理优化

偏移量提交策略:

1. 自动提交:

enable.auto.commit=true

auto.commit.interval.ms=5000 // 每5秒提交一次

2. 手动同步提交:

consumer.commitSync(); // 阻塞直到提交成功

3. 手动异步提交:

consumer.commitAsync(callback); // 非阻塞,有回调

偏移量存储演进:

┌─────────────────────────────────────────────┐

│ Kafka 0.8.2之前:ZooKeeper存储偏移量 │

│ 问题:ZK不是为高频率写设计,性能瓶颈 │

├─────────────────────────────────────────────┤

│ Kafka 0.8.2之后:__consumer_offsets Topic │

│ 优势: │

│ 1. Kafka自身存储,高性能 │

│ 2. 压缩日志段,节省空间 │

│ 3. 副本机制,高可用性 │

└─────────────────────────────────────────────┘

__consumer_offsets内部结构:

键:group+topic+partition的哈希

值:偏移量+元数据

压缩策略:cleanup.policy=compact // 只保留最新偏移量小结

Kafka的高性能来自多个层次的协同优化:

- 存储层:顺序I/O + 页缓存 + 零拷贝

- 网络层:Reactor模型 + 批量处理 + 长连接

- 内存层:内存池 + 堆外内存 + 压缩传输

- 架构层:分区并行 + Leader-Follower + ISR

- 协议层:高效消息格式 + 稀疏索引 + 增量编码

Kafka 分区的目的?能提供什么能力

分区对于Kafka 集群的好处是:实现负载均衡。

分区对于消费者来说,可以提高并发度,提高效率,当然,对于是生产者也可以提高并行度的目的,将数据写入多个分区,提高写入速度,各个分区都是独立的,不会产生并发安全问题。

如果我们假设像标准 MQ 的 Queue, 为了保证一个消息只会被一个消费者消费, 那么我们第一想到的就是加锁. 对于发送者, 在多线程并且非顺序写环境下, 保证数据一致性, 我们同样也要加锁. 一旦考虑到加锁, 就会极大的影响性能.

我们再来看Kafka 的 Partition, Kafka 的消费模式和发送模式都是以 Partition 为分界. 也就是说对于一个 Topic 的并发量限制在于有多少个 Partition, 就能支撑多少的并发. 可以参考 Java 1.7 的 ConcurrentHashMap 的桶设计, 原理一样, 有多少桶, 支持多少的并发

kafka分区能提供的能力:

并行处理能力扩展

并行处理能力扩展 ,方便对每一个topic分区进行横向扩展;

- 每条消息根据分区策略分配到不同分区,分区选择策略

- 指定分区:直接发送到指定分区

- Key哈希:相同Key到同一分区(保证顺序)

- 轮询:均匀分布到所有分区

- 粘性:批次内消息尽量发到同一分区

性能优势:多分区并行写入 vs 单分区串行写入

水平扩展与负载均衡

- 可以对单个topic的分区进行水平扩展,并不影响查询效率;

- 磁盘空间:增加分区可扩展到更多磁盘

- IOPS能力:多分区分散IO压力

- 网络带宽:多Broker并行服务

消费者扩展性

可以动态对消费者扩缩容,只要触发重平衡即可;有多种分区策略可以选择L

- RangeAssignor(默认策略)

- RoundRobinAssignor(轮询分配)

- StickyAssignor(粘性分配,Kafka 0.11+)

- 尽可能均衡分配

- 再平衡时最小化分区移动

- 保持消费状态局部性

消费者扩展性限制原则:

- 分区数是消费者并行度的上限

- 消费者数 ≤ 分区数

- 多余消费者将处于空闲状态

数据有序性保证

// 分区内的消息顺序性实现

public class PartitionLog {

private final long[] offsets; // 严格递增的偏移量

private final LogSegment[] segments;

public void append(ProducerId producerId,

int producerEpoch,

int sequence,

byte[] message) {

// 幂等生产者顺序保证

if (isIdempotentProducer(producerId)) {

// 检查序列号连续性

if (sequence != lastSequence + 1) {

throw new OutOfOrderSequenceException();

}

lastSequence = sequence;

}

// 分配单调递增的偏移量

long offset = nextOffset.getAndIncrement();

// 顺序写入日志文件

logSegment.append(offset, message);

// 更新高水位(HW)

updateHighWatermark(offset);

}

// 读取时保证顺序

public List<Message> read(long startOffset, int maxSize) {

// 从startOffset开始,按偏移量顺序返回消息

// 偏移量严格递增:0,1,2,3,4,5...

return fetchOrderedMessages(startOffset, maxSize);

}

}顺序保证

不同场景的顺序性需求:

1. 完全有序(单分区):

Topic: "bank-transactions"

Partition: 1(所有消息发到同一分区)

优势:严格保证全局顺序

代价:无法并行,吞吐量受限

2. 分组有序(Key-based分区):

Topic: "user-actions"

分区策略:hash(userId) % numPartitions

效果:同一用户的操作有序,不同用户并行处理

┌──────────┬─────────────┐

│ User A │ Partition 0 │ → 顺序处理A的所有操作

│ User B │ Partition 1 │ → 顺序处理B的所有操作

│ User C │ Partition 2 │ → 顺序处理C的所有操作

└──────────┴─────────────┘

3. 无序处理(无Key轮询):

Topic: "metrics-data"

分区策略:RoundRobin

效果:最大并行度,无顺序保证负载均衡

- 生产者和Broker间的负载均衡

public class ProducerLoadBalancer {

// 分区Leader分布优化

public Map<Integer, Node> partitionLeaders(TopicPartition tp) {

// Kafka控制器确保:

// 1. 每个Broker的Leader分区数尽量均衡

// 2. 副本分布在不同的机架(如果配置了机架感知)

// 3. Leader在ISR中均匀分布

// 机架感知配置(broker.rack):

// Broker1: rack1

// Broker2: rack2

// Broker3: rack3

// 副本分配策略:

// 第一个副本:随机选择

// 第二个副本:不同机架的Broker

// 第三个副本:与前两个不同机架

}

// 生产者负载均衡策略

public int choosePartition(String topic, Object key, byte[] value) {

if (key != null) {

// 哈希分区:相同Key到相同分区

return hash(key) % numPartitions;

} else if (stickyPartitioningEnabled) {

// 粘性分区:批次内消息尽量发到同一分区

return getStickyPartition(topic);

} else {

// 轮询分区:均匀分布

return roundRobinPartition(topic);

}

}

}读写负载分离

读写分离架构:

┌─────────────┐

│ Producer1 │

└──────┬──────┘

│

┌───────────────┼───────────────┐

│ ▼ │

┌───────┴──────┐ ┌─────────────┐ ┌─────┴──────┐

│ Broker1 │ │ Broker2 │ │ Broker3 │

│ Partition0-L │ │ Partition1-L│ │ Partition2-L│

│ Partition1-F │ │ Partition2-F│ │ Partition0-F│

│ Partition2-F │ │ Partition0-F│ │ Partition1-F│

└──────────────┘ └─────────────┘ └────────────┘

│ │ │

└───────────────┼───────────────┘

▼

┌─────────────┐

│ Consumer │

│ Group │

└─────────────┘

Leader-Follower机制:

- Leader处理所有读写请求

- Follower异步复制数据

- 故障时从ISR选举新Leader

- 读写负载集中在Leader,Follower备用故障容错与高可用性

- 分区副本机制

class ReplicaManager {

// 副本同步状态管理

private Map<TopicPartition, PartitionState> partitions;

class PartitionState {

int leaderId; // Leader副本所在Broker

List<Integer> isr; // 同步副本集合

long hw = 0L; // 高水位

long leo = 0L; // 日志末端偏移

// ISR维护

public void updateReplicaState(int replicaId, long replicaLeo) {

// 副本落后检查

long lag = leo - replicaLeo;

if (lag <= replica.lag.time.max.ms) {

// 副本同步,保持在ISR中

if (!isr.contains(replicaId)) {

isr.add(replicaId);

}

} else {

// 副本落后,从ISR移除

isr.remove(replicaId);

}

}

// Leader选举

public void electNewLeader() {

// 从ISR中选择新的Leader

// 优先选择leo最高的副本

// 确保数据不丢失(至少有一个副本有完整数据)

if (isr.isEmpty()) {

// 无同步副本,可能数据丢失

if (unclean.leader.election.enable) {

// 允许从不同步副本选举(可能丢失数据)

electLeaderFromAllReplicas();

} else {

throw new NoLeaderElectedException();

}

} else {

// 从ISR中选举

electLeaderFromISR();

}

}

}

}腹胀恢复流程

Broker故障处理流程:

1. 故障检测:

- ZooKeeper会话超时(session.timeout.ms)

- Controller监控Broker状态变化

2. Leader重新选举:

for 每个受影响的Partition {

if (旧Leader在故障Broker上) {

// 从ISR中选择新Leader

新Leader = ISR中第一个可用副本

// 更新元数据

Metadata更新新Leader信息

// 生产者重定向

生产者连接到新Leader

}

}

3. 副本同步:

- 新Leader开始服务请求

- 其他Follower从新Leader同步数据

- 追赶上后重新加入ISR

4. 恢复完成:

- 所有分区有新Leader

- ISR重新稳定

- 继续正常服务数据局部性与性能优化

数据局部性设计

// 消费者从最近副本拉取(机架感知)

public class RackAwareConsumer {

private String consumerRack; // 消费者所在机架

public void fetchData(TopicPartition tp) {

// 获取分区副本列表

List<Node> replicas = cluster.partitionReplicas(tp);

// 优先选择同机架副本(如果启用机架感知)

Node preferredReplica = null;

for (Node replica : replicas) {

if (replica.rack().equals(consumerRack)) {

preferredReplica = replica;

break;

}

}

// 如果同机架没有可用副本,选择其他副本

Node targetReplica = (preferredReplica != null) ?

preferredReplica : replicas.get(0);

// 从该副本拉取数据(可能是Follower)

fetchFromReplica(tp, targetReplica);

}

}磁盘I/O优化

分区数据局部性优势:

1. 顺序I/O保持:

每个分区独立日志文件 → 保证分区内顺序写入

┌─────────────────┐

│ partition-0.log │ ← 顺序写入

│ partition-1.log │ ← 顺序写入

│ partition-2.log │ ← 顺序写入

└─────────────────┘

2. 热点分散:

// 没有分区:所有请求集中到一个文件

// 有分区:请求分散到多个文件/磁盘

热点用户请求分布:

┌─────────────────────────────────────┐

│ 用户A(高频)→ Partition 0 → Disk1 │

│ 用户B(高频)→ Partition 1 → Disk2 │

│ 用户C(高频)→ Partition 2 → Disk3 │

│ 用户D(低频)→ Partition 3 → Disk1 │

└─────────────────────────────────────┘

3. 索引局部性:

每个分区有自己的索引文件

- 索引更小,缓存命中率更高

- 索引更新不影响其他分区灵活的数据组织与消费模式

多种消费模式支持

// 1. 队列模式(竞争消费者)

public class QueueMode {

// 一个分区只能被一个消费者消费

// 适合任务分发场景

public void queueConsumer() {

Properties props = new Properties();

props.put("group.id", "task-workers");

// 多个消费者共享负载

}

}

// 2. 发布订阅模式

public class PubSubMode {

// 多个消费者组独立消费所有消息

public void pubSubConsumer() {

// 组A:实时报警

Properties propsA = new Properties();

propsA.put("group.id", "alerts-group");

// 组B:数据归档

Properties propsB = new Properties();

propsB.put("group.id", "archive-group");

// 组C:实时分析

Properties propsC = new Properties();

propsC.put("group.id", "analytics-group");

// 所有组独立消费全部数据

}

}

// 3. 重播与回溯消费

public class ReplayConsumer {

public void replayFromOffset(TopicPartition tp, long offset) {

// 可以指定任意偏移量开始消费

consumer.seek(tp, offset);

// 使用场景:

// - 错误恢复:重处理失败的消息

// - 数据修复:重新计算错误结果

// - 测试调试:重复特定场景

}

}

// 4. Exactly-Once处理

public class ExactlyOnceProcessor {

// 使用事务API保证端到端精确一次

public void processExactlyOnce() {

producer.initTransactions();

try {

producer.beginTransaction();

// 消费消息

ConsumerRecords records = consumer.poll();

// 处理并生产新消息

for (ConsumerRecord record : records) {

Message result = process(record.value());

producer.send(new ProducerRecord("output", result));

}

// 提交偏移量作为事务的一部分

Map<TopicPartition, OffsetAndMetadata> offsets =

consumerOffsets(records);

producer.sendOffsetsToTransaction(offsets, "group-id");

producer.commitTransaction();

} catch (Exception e) {

producer.abortTransaction();

}

}

}说一下什么是副本?

kafka 为了保证数据不丢失,从 0.8.0 版本开始引入了分区副本机制。在创建 topic 的时候指定 replication-factor,默认副本为 3 。

副本是相对 partition 而言的,一个分区中包含一个或多个副本,其中一个为leader 副本,其余为follower 副本,各个副本位于不同的 broker 节点中。

所有的读写操作都是经过 Leader 进行的,同时 follower 会定期地去 leader 上复制数据。当 Leader 挂掉之后,其中一个 follower 会重新成为新的 Leader。通过分区副本,引入了数据冗余,同时也提供了 Kafka 的数据可靠性。

Kafka 的分区多副本架构是 Kafka 可靠性保证的核心,把消息写入多个副本可以使 Kafka 在发生崩溃时仍能保证消息的持久性。

副本的类型

副本类型分类:

┌─────────────────────────────────────────────────────┐

│ Kafka副本体系 │

├─────────────────────────────────────────────────────┤

│ Leader副本 (1个) │

│ ┌─────────────────────────────────────────┐ │

│ │ • 处理所有读写请求 │ │

│ │ • 维护ISR列表 │ │

│ │ • 推进高水位(HW) │ │

│ └─────────────────────────────────────────┘ │

│ │

│ Follower副本 (N-1个) │

│ ┌─────────────────────────────────────────┐ │

│ │ • 从Leader拉取数据 │ │

│ │ • 不直接服务客户端请求 │ │

│ │ • 故障时可能成为新Leader │ │

│ └─────────────────────────────────────────┘ │

│ │

│ ISR (In-Sync Replicas) │

│ ┌─────────────────────────────────────────┐ │

│ │ • 与Leader保持同步的副本集合 │ │

│ │ • 参与Leader选举 │ │

│ │ • 决定消息的提交状态 │ │

│ └─────────────────────────────────────────┘ │

│ │

│ OSR (Out-of-Sync Replicas) │

│ ┌─────────────────────────────────────────┐ │

│ │ • 落后于Leader的副本 │ │

│ │ • 不参与Leader选举 │ │

│ │ • 不保证数据一致性 │

│ └─────────────────────────────────────────┘ │

└─────────────────────────────────────────────────────┘kafka之所以设计副本机制,需要从以下几个方面考虑:

数据高可用性(核心价值)

在Broker宕机的情况下,保证仍可以对外提供读写能力;

没有副本的情况:

┌─────────────────────────────────────────┐

│ 初始状态:TopicA-Partition0在Broker1 │

├─────────────────────────────────────────┤

│ Producer → 写消息 → Broker1 │

│ Consumer ← 读消息 ← Broker1 │

└─────────────────────────────────────────┘

↓ Broker1宕机

┌─────────────────────────────────────────┐

│ 故障状态:数据不可访问 │

├─────────────────────────────────────────┤

│ Producer → 写失败(NoLeader) │

│ Consumer ← 读失败(分区不可用) │

│ 结果:服务中断,数据丢失 │

└─────────────────────────────────────────┘

有副本的情况(副本因子=3):

┌─────────────────────────────────────────┐

│ 初始状态: │

│ TopicA-Partition0 在 3个Broker上有副本 │

├─────────────────────────────────────────┤

│ Leader: Broker1 │

│ Followers: Broker2, Broker3 │

│ │

│ Producer → 写消息 → Leader(Broker1) │

│ ↓ 同步复制 │

│ Follower(Broker2) │

│ Follower(Broker3) │

└─────────────────────────────────────────┘

↓ Broker1宕机

┌─────────────────────────────────────────┐

│ 故障恢复:自动Leader选举 │

├─────────────────────────────────────────┤

│ 1. Controller检测到Broker1故障 │

│ 2. 从ISR中选择新Leader(如Broker2) │

│ 3. 更新元数据 │

│ 4. Producer/Consumer重定向到新Leader │

│ │

│ 结果:服务无感知切换,数据不丢失 │

└─────────────────────────────────────────┘数据持久性保证

写入确认机制

// 不同acks配置下的副本行为

public class ProducerDurability {

// acks=0:不等待确认(可能丢失数据)

public void sendFireAndForget() {

Properties props = new Properties();

props.put("acks", "0"); // 不等待任何确认

// 写入Leader本地缓存即返回成功

// 数据可能丢失:Leader故障且未同步到Follower

}

// acks=1:等待Leader确认(默认,平衡方案)

public void sendLeaderAck() {

Properties props = new Properties();

props.put("acks", "1"); // 等待Leader写入成功

// 流程:

// 1. Producer发送消息到Leader

// 2. Leader写入本地日志(页缓存)

// 3. Leader返回成功确认

// 4. Leader异步同步给Followers

// 风险:Leader写入成功后故障,新Leader可能没有该数据

}

// acks=all/-1:等待所有ISR确认(最高持久性)

public void sendAllReplicasAck() {

Properties props = new Properties();

props.put("acks", "all"); // 等待所有ISR副本确认

props.put("min.insync.replicas", "2"); // 最小ISR数

// 流程:

// 1. Producer发送消息到Leader

// 2. Leader写入本地日志

// 3. Leader等待所有ISR副本写入成功

// - 如果ISR数量 ≥ min.insync.replicas

// - 等待所有ISR副本确认

// 4. 所有ISR确认后,返回成功给Producer

// 保证:只要min.insync.replicas个副本存活,数据就不会丢失

}

}数据丢失概率对比

不同配置下的数据丢失概率:

┌───────────────┬──────────────┬──────────────┬──────────────┐

│ acks配置 │ 副本因子 │ min.insync. │ 数据丢失概率 │

│ │ │ replicas │ │

├───────────────┼──────────────┼──────────────┼──────────────┤

│ acks=0 │ 任意 │ - │ 高 │

│ │ │ │ (写缓存失败) │

├───────────────┼──────────────┼──────────────┼──────────────┤

│ acks=1 │ 1 │ - │ 非常高 │

│ │ │ │ (单点故障) │

├───────────────┼──────────────┼──────────────┼──────────────┤

│ acks=1 │ 3 │ - │ 中等 │

│ │ │ │ (Leader故障) │

├───────────────┼──────────────┼──────────────┼──────────────┤

│ acks=all │ 3 │ 2 │ 非常低 │

│ │ │ │ (需2副本故障) │

├───────────────┼──────────────┼──────────────┼──────────────┤

│ acks=all │ 3 │ 3 │ 极低 │

│ │ │ │ (需3副本故障) │

└───────────────┴──────────────┴──────────────┴──────────────┘读写负载分离与扩展

读写分离架构

// Follower副本的读能力(Kafka 2.4+)

public class FollowerRead {

// 副本读取配置

Properties props = new Properties();

props.put("replica.selector.class",

"org.apache.kafka.common.replica.RackAwareReplicaSelector");

// 消费者可以从Follower读取的情况:

// 1. 启用机架感知(减少跨机房流量)

// 2. Leader负载过高时

// 3. 网络分区导致无法访问Leader

// 优势:

// - 减轻Leader压力

// - 就近读取(减少延迟)

// - 提高读取吞吐量

}负载分布示例

读写负载分布优化:

场景:3副本,跨机房部署

┌─────────────────────────────────────────────────────┐

│ 机房A (北京) │ 机房B (上海) │

├─────────────────────────────────────────────────────┤

│ Broker1 │ Broker2 │

│ Partition0-Leader │ Partition0-Follower │

│ Partition1-Follower │ Partition1-Leader │

│ Partition2-Follower │ Partition2-Leader │

├─────────────────────────────────────────────────────┤

│ 北京用户: │ 上海用户: │

│ • 写:全部到Leader │ • 写:全部到Leader │

│ • 读:优先本地Follower │ • 读:优先本地Follower │

│ 减少跨机房延迟 │ 减少跨机房延迟 │

└─────────────────────────────────────────────────────┘

效果:

1. 写负载:集中在Leader,保证一致性

2. 读负载:分散到多个Follower,提高读取能力

3. 网络优化:减少跨机房流量

4. 故障隔离:机房故障不影响另一个机房读取数据一致性保证

副本同步机制

// Follower副本同步流程

class ReplicaFetcherThread extends Thread {

public void run() {

while (running) {

// 1. 发送Fetch请求到Leader

FetchRequest request = buildFetchRequest();

// 2. 拉取数据

FetchResponse response = sendFetchToLeader(request);

// 3. 写入本地日志

for (FetchResponse.PartitionData partitionData : response) {

// 验证数据完整性

validateChecksums(partitionData);

// 写入本地日志文件

log.append(partitionData.records);

// 更新本地LEO(Log End Offset)

updateLogEndOffset(partitionData.highWatermark);

// 发送确认给Leader

sendFetchResponseToLeader(partitionData);

}

// 4. 更新同步状态

updateReplicaState(response);

}

}

}

// Leader端的副本同步管理

class ReplicaManager {

// ISR维护算法

public void updateISRState(int replicaId, long replicaLEO) {

PartitionState partition = getPartitionState();

// 计算副本落后程度

long lag = partition.leaderLEO - replicaLEO;

// 判断是否同步

if (lag <= replica.lag.time.max.ms && // 时间落后阈值

lag <= replica.lag.max.messages) { // 消息数落后阈值

// 同步副本,保持在ISR中

if (!partition.isr.contains(replicaId)) {

partition.isr.add(replicaId);

zkClient.updateISR(partition); // 更新ZK

}

} else {

// 落后太多,移出ISR

if (partition.isr.contains(replicaId)) {

partition.isr.remove(replicaId);

zkClient.updateISR(partition);

}

}

}

}数据一致性模型

Kafka的副本一致性保证:

1. 最终一致性:

- 正常情况下,所有副本最终会同步

- 同步延迟取决于网络和负载

2. 读写一致性:

- 写后读:写操作成功后,后续读能看到数据

- 单调读:同一消费者不会读到旧数据

3. 故障时的一致性保证:

┌─────────────────────────────────────────┐

│ 场景:Leader故障,从ISR选举新Leader │

├─────────────────────────────────────────┤

│ 数据状态: │

│ • 已提交消息(committed):不会丢失 │

│ 定义:被所有ISR副本持久化的消息 │

│ • 未提交消息(uncommitted):可能丢失 │

│ Leader写入但未同步到所有ISR │

└─────────────────────────────────────────┘

4. 高水位(High Watermark)机制:

- HW:消费者能读取的最新消息边界

- LEO:Leader最后写入的消息位置

- 只有HW之前的消息被认为是"已提交"

┌───┬───┬───┬───┬───┬───┐ 偏移量

│ 0 │ 1 │ 2 │ 3 │ 4 │ 5 │

└───┴───┴───┴─┬─┴───┴───┘

│

HW=3 (消费者只能读到0-2)

LEO=5 (Leader已写入0-4)

已提交:0,1,2

未提交:3,4(Leader故障时可能丢失)副本工作机制详解

副本分配策略

class ReplicaAssignment {

// Kafka副本分配算法

public List<Integer> assignReplicasToBrokers(

int numReplicas,

int numBrokers,

int brokerStartIndex, // 起始Broker索引

int startPartitionId) {

List<Integer> replicaAssignment = new ArrayList<>();

// 核心原则:

// 1. 第一个副本:按分区号轮询分配

// 2. 后续副本:与前一个副本在不同Broker

// 3. 机架感知:尽可能跨机架分布

// 示例:6个分区,3副本,6个Broker

// 分区0副本:[0, 1, 2]

// 分区1副本:[1, 2, 3]

// 分区2副本:[2, 3, 4]

// 分区3副本:[3, 4, 5]

// 分区4副本:[4, 5, 0]

// 分区5副本:[5, 0, 1]

// 机架感知时:

// 假设机架分布:Broker[0,1]在RackA,[2,3]在RackB,[4,5]在RackC

// 分区0副本:[0(RackA), 2(RackB), 4(RackC)] ← 跨机架

return replicaAssignment;

}

}分配案例

副本分配可视化:

Broker分布:B1(rack1), B2(rack1), B3(rack2), B4(rack2), B5(rack3), B6(rack3)

Topic: orders,4个分区,副本因子3

┌─────────────┬─────────────────────────────┐

│ 分区 │ 副本分配(Broker ID) │

├─────────────┼─────────────────────────────┤

│ Partition 0 │ [B1(rack1), B3(rack2), B5(rack3)] ← 跨3个机架

│ Partition 1 │ [B2(rack1), B4(rack2), B6(rack3)] ← 跨3个机架

│ Partition 2 │ [B3(rack2), B5(rack3), B1(rack1)] ← Leader轮换

│ Partition 3 │ [B4(rack2), B6(rack3), B2(rack1)] ← 均衡分布

└─────────────┴─────────────────────────────┘

Leader分布统计:

• B1: Partition0 Leader

• B2: Partition1 Leader

• B3: Partition2 Leader

• B4: Partition3 Leader

每个Broker都是1个Leader,完全均衡Leader选举机制

class PartitionLeaderElection {

// 控制器(Controller)负责的Leader选举

public void onBrokerFailure(int failedBrokerId) {

// 1. 找出所有受影响的分区

List<TopicPartition> affectedPartitions =

findPartitionsWithLeader(failedBrokerId);

for (TopicPartition tp : affectedPartitions) {

// 2. 获取分区状态

PartitionState state = getPartitionState(tp);

// 3. 从ISR中选择新Leader

List<Integer> isr = state.isr;

isr.remove(failedBrokerId); // 移除故障副本

if (!isr.isEmpty()) {

// 优先选择:第一个同步副本作为新Leader

int newLeaderId = isr.get(0);

// 4. 更新元数据

updateLeaderAndIsr(tp, newLeaderId, isr);

// 5. 发送LeaderAndIsr请求给相关Broker

sendLeaderAndIsrRequest(tp, newLeaderId, isr);

// 6. 更新所有Broker的元数据缓存

updateMetadataCache(tp, newLeaderId, isr);

} else {

// ISR为空的情况

if (unclean.leader.election.enable) {

// 允许从非同步副本选举(可能丢失数据)

int newLeaderId = electFromOutOfSyncReplicas(tp);

handleUncleanElection(tp, newLeaderId);

} else {

// 分区不可用

markPartitionOffline(tp);

}

}

}

}

// 优雅关闭时的Leader转移

public void onBrokerShutdown(int brokerId) {

// 1. 控制器将broker标记为关闭状态

// 2. 对该broker上的每个Leader分区:

// a. 从ISR中移除该broker

// b. 触发Leader选举(优选其他ISR副本)

// 3. 平滑转移,减少不可用时间

}

}选举策略对比

Leader选举策略比较:

┌─────────────────┬─────────────────┬─────────────────┬─────────────────┐

│ 选举类型 │ 触发条件 │ 选举范围 │ 数据一致性 │

├─────────────────┼─────────────────┼─────────────────┼─────────────────┤

│ 干净选举 │ ISR非空 │ 仅限ISR内副本 │ 保证不丢失 │

│ (Clean) │ │ │ 已提交数据 │

├─────────────────┼─────────────────┼─────────────────┼─────────────────┤

│ 不干净选举 │ ISR为空 │ 所有存活副本 │ 可能丢失 │

│ (Unclean) │ 且配置允许 │ │ 未提交数据 │

├─────────────────┼─────────────────┼─────────────────┼─────────────────┤

│ 首选副本选举 │ 自动均衡 │ 首选副本 │ 无数据丢失 │

│ (Preferred) │ 或手动触发 │ (第一个副本) │ 风险 │

├─────────────────┼─────────────────┼─────────────────┼─────────────────┤

│ 控制器切换选举 │ 控制器故障 │ 新控制器决定 │ 取决于新控制 │

│ │ │ │ 器选举策略 │

└─────────────────┴─────────────────┴─────────────────┴─────────────────┘

配置建议:

# 生产环境推荐

unclean.leader.election.enable=false # 禁止不干净选举

auto.leader.rebalance.enable=true # 启用自动均衡

leader.imbalance.check.interval.seconds=300

leader.imbalance.per.broker.percentage=10副本同步机制

class ReplicaSyncMechanism {

// Follower同步状态机

enum ReplicaState {

ONLINE, // 正常在线

OFFLINE, // 离线

LOG_DIR_FAILURE, // 日志目录故障

SHUTTING_DOWN // 正在关闭

}

// 同步延迟监控

class ReplicaFetcherMetrics {

// 关键指标

long replicaLag; // 副本落后消息数

long replicaLagTimeMs; // 副本落后时间(ms)

double fetchRate; // 拉取速率

long fetchLatencyAvg; // 拉取延迟

// 阈值配置

long replicaLagMaxMessages = 4000; // 最大落后消息数

long replicaLagTimeMaxMs = 30000; // 最大落后时间

}

// 限流与背压机制

class ReplicaQuotaManager {

// 副本同步限流配置

long followerReplicationThrottledRate = 10 * 1024 * 1024; // 10MB/s

long leaderReplicationThrottledRate = 20 * 1024 * 1024; // 20MB/s

// 限流场景:

// 1. 新副本加入时全量同步

// 2. 副本长时间离线后重新同步

// 3. 避免同步影响正常服务

}

}ISR动态维护

ISR维护流程:

时间线示例:

t0: ISR=[1,2,3], LEO=100

Leader(B1)收到新消息,LEO=101

Follower B2拉取到101,LEO=101

Follower B3网络延迟,LEO=100

t1: Leader检查副本状态

B2 lag = 101-101 = 0 (同步)

B3 lag = 101-100 = 1 (落后)

t2: B3网络恢复,拉取到101

B3 lag = 101-101 = 0

t3: Leader定期检查(每replica.lag.time.max.ms=10s)

B2: 在ISR中,保持

B3: 落后时间<10s,重新加入ISR

t4: B3再次网络故障,10秒未同步

Leader将B3移出ISR,ISR=[1,2]

t5: B3恢复,开始追赶

当B3的LEO >= HW时,重新加入ISR

关键参数:

• replica.lag.time.max.ms: 副本最大落后时间(默认30s)

• replica.lag.max.messages: 副本最大落后消息数(已废弃)

• min.insync.replicas: 最小ISR数量(影响可用性)副本机制带来的性能开销

副本机制带来的性能开销:

1. 网络开销:

┌─────────────────────────────────────────┐

│ 写入放大因子 = 副本数 │

│ 示例:写入1MB数据,副本因子=3 │

│ • 生产者 → Leader: 1MB │

│ • Leader → Follower1: 1MB │

│ • Leader → Follower2: 1MB │

│ 总网络流量:3MB(放大3倍) │

└─────────────────────────────────────────┘

2. 磁盘I/O开销:

• 每个副本都需要写入磁盘

• 副本越多,集群总磁盘写入量越大

• 可能成为磁盘性能瓶颈

3. 内存开销:

• 每个副本维护独立的页缓存

• 副本越多,总内存需求越大

4. 选举开销:

• Leader故障触发重新选举

• 选举期间分区不可用

• 元数据更新开销一致性、可用性、延迟的权衡

CAP理论在Kafka中的体现

Kafka的CAP权衡:

C(一致性):

• 使用ISR和HW机制保证副本间一致性

• acks=all时提供强一致性保证

• 但可能牺牲可用性(ISR不足时拒绝写入)

A(可用性):

• 副本机制提供高可用性

• Leader故障可自动切换

• 但一致性可能受损(不干净选举时)

P(分区容错性):

• 天生支持网络分区

• 副本分布在多个Broker

• 脑裂问题通过ZooKeeper/Controller解决

实际设计选择:

┌─────────────────────────────────────────┐

│ Kafka的默认选择:优先CP,兼顾A │

├─────────────────────────────────────────┤

│ 配置acks=all, min.insync.replicas=2时: │

│ • 保证一致性(C) │

│ • 容忍部分节点故障(P) │

│ • 但可能牺牲可用性(A不足时拒绝写入) │

└─────────────────────────────────────────┘

用户可根据业务需求调整:

• 支付系统:优先C(acks=all, min.insync.replicas≥2)

• 日志收集:优先A(acks=1, 允许不干净选举)

• 监控数据:优先P(acks=0, 最大吞吐)Kafka消息是采用Pull模式,还是Push模式?

Kafka最初考虑的问题是,cusumer应该从brokes拉取消息还是brokers将消息推送到consumer,也就是pull还push。在这方面,Kafka遵循了一种大部分消息系统共同的传统的设计:producer将消息推送到broker,consumer从broker拉取消息。

一些消息系统比如Scribe和Apache Flume采用了push模式,将消息推送到下游的consumer。这样做有好处也有坏处:由broker决定消息推送的速率,对于不同消费速率的consumer就不太好处理了。消息系统都致力于让consumer以最大的速率最快速的消费消息,但不幸的是,push模式下,当broker推送的速率远大于consumer消费的速率时,consumer恐怕就要崩溃了。最终Kafka还是选取了传统的pull模式

Pull模式的另外一个好处是consumer可以自主决定是否批量的从broker拉取数据。Push模式必须在不知道下游consumer消费能力和消费策略的情况下决定是立即推送每条消息还是缓存之后批量推送。如果为了避免consumer崩溃而采用较低的推送速率,将可能导致一次只推送较少的消息而造成浪费。Pull模式下,consumer就可以根据自己的消费能力去决定这些策略

Pull有个缺点是,如果broker没有可供消费的消息,将导致consumer不断在循环中轮询,直到新消息到t达。为了避免这点,Kafka有个参数可以让consumer阻塞知道新消息到达(当然也可以阻塞知道消息的数量达到某个特定的量这样就可以批量发。

请说明Kafka相对于传统的消息传递方法有什么优势?

- 高性能:单一的Kafka代理可以处理成千上万的客户端,每秒处理数兆字节的读写操作,Kafka性能远超过传统的ActiveMQ、RabbitMQ等,而且Kafka支持Batch操作

- 可扩展:Kafka集群可以透明的扩展,增加新的服务器进集群

- 容错性: Kafka每个Partition数据会复制到几台服务器,当某个Broker失效时,Zookeeper将通知生产 者和消费者从而使用其他的Broker。

- 高吞吐、低延迟:kakfa 最大的特点就是收发消息非常快,kafka 每秒可以处理几十万条消息,它的最低延迟只有几毫秒。

- 高伸缩性: 每个主题(topic) 包含多个分区(partition),主题中的分区可以分布在不同的主机(broker)中。

- 持久性、可靠性: Kafka 能够允许数据的持久化存储,消息被持久化到磁盘,并支持数据备份防止数据丢失,Kafka 底层的数据存储是基于 Zookeeper 存储的,Zookeeper 我们知道它的数据能够持久存储。

Kafka与传统消息队列的区别?

在说区别的时候,我们先来看看kafka的应用场景:

kafka是个日志处理缓冲组件,在大数据信息处理中使用。和传统的消息队列相比较简化了队列结构和功能,以流形式处理存储(持久化)消息(主要是日志)。日志数据量巨大,处理组件一般会处理不过来,所以作为缓冲曾的kafka,支持巨大吞吐量。为了防止信息丢失,其消息被消费后不直接丢弃,要多存储一段时间,等过期时间过了才丢弃。这是mq和redis不能具备的。

主要特点入下:

巨型存储量:

- 支持TB甚至PB级别数据,因为数据是持久化在磁盘,因此可以做到大数据量的存储;

高吞吐,高IO:

- 一般配置的服务器能实现单机每秒100K条以上消息的传输。

消息分区,分布式消费:

- 首先kafka会将接收到的消息分区(partition),每个主题(topic)的消息有不同的分区,这样一方面消息的存储就不会受到单一服务器存储空间大小的限制,另一方面消息的处理也可以在多个服务器上并行。也做到了负载均衡的目的,将数据均衡到堕胎服务器的多个分区中。

- 能保消息顺序传输。 支持离线数据处理和实时数据处理。

Scale out:

- 支持在线水平扩展,以支持更大数据处理量。

高可用机制:

- 其次为了保证高可用,每个分区都会有一定数量的副本(replica)。这样如果有部分服务器不可用,副本所在的服务器就会接替上来,保证应用的持续性。

- 然后保证分区内部消息的消费有序性。

消费者组:

- Kafka还具有consumer group的概念,每个分区只能被同一个group的一个consumer消费,但可以被多个group消费。

而传统的消息队列,比如Rides:

redis只是提供一个高性能的、原子操作内存键值队,具有高速访问能力,可用做消息队列的存储,但是不具备消息队列的任何功能和逻辑,要作做为消息队列来实现的话,功能和逻辑要通过上层应用自己实现。

redis 消息推送(基于分布式 pub/sub)多用于实时性较高的消息推送,并不保证可靠。

作为消息队列来说,企业中选择mq的还是多数,因为像Rabbit,Rocket等mq中间件都属于很成熟的产品,性能一般但可靠性较强,而kafka原本设计的初衷是日志统计分析,现在基于大数据的背景下也可以做运营数据的分析统计,而redis的主要场景是内存数据库,作为消息队列来说可靠性太差,而且速度太依赖网络IO,在服务器本机上的速度较快,且容易出现数据堆积的问题,在比较轻量的场合下能够适用

我们还是以RabbitMQ为例介绍。它是用Erlang语言开发的开源的消息队列,支持多种协议,包括AMQP,XMPP, SMTP, STOMP。适合于企业级的开发。

MQ支持Broker构架,消息发送给客户端时需要在中心队列排队。对路由,负载均衡或者数据持久化都有很好的支持。

Kafka判断一个节点是否还活着有那两个条件?

ZooKeeper会话保持(Session Maintenance)

节点必须可以维护和ZooKeeper的连接,Zookeeper通过心跳机制检查每个节点的连接

会话维护机制

ZooKeeper会话心跳机制:

┌─────────────────────────────────────────────────────────┐

│ ZooKeeper Server Cluster │

│ │

│ ┌─────────────────────────────────────────────┐ │

│ │ Session Tracking │ │

│ │ • Session ID: 0x1234567890abcdef │ │

│ │ • Timeout: 18000ms │ │

│ │ • Last Ping Time: t₀ │ │

│ └─────────────────────────────────────────────┘ │

└───────────────────────────┬───────────────────────────┘

│ 心跳检测

▼

┌─────────────────────────────────────────────────────────┐

│ Kafka Broker │

│ │

│ ┌─────────────────────────────────────────────┐ │

│ │ Session Heartbeat Thread │ │

│ │ │ │

│ │ while (running) { │ │

│ │ // 定期发送心跳 │ │

│ │ zkClient.ping(); │ │

│ │ │ │

│ │ // 关键配置参数: │ │

│ │ // zookeeper.session.timeout.ms │ │

│ │ // 默认18000ms(18秒) │ │

│ │ │ │

│ │ // 心跳间隔: │ │

│ │ // timeout / 3 ≈ 6000ms(6秒) │ │

│ │ Thread.sleep(heartbeatInterval); │ │

│ │ } │ │

│ └─────────────────────────────────────────────┘ │

└─────────────────────────────────────────────────────────┘

故障检测时间线:

t0: Broker正常,发送心跳 ✓

t1: Broker故障(如JVM崩溃)

t2: ZooKeeper等待下一个心跳(6秒后) ✗ 未收到

t3: ZooKeeper继续等待(12秒后) ✗ 未收到

t4: ZooKeeper会话过期(18秒后)→ 标记Broker为死亡

实际检测时间 = sessionTimeoutMs = 18000ms相关配置参数

# ZooKeeper会话相关配置

# Broker端配置

zookeeper.session.timeout.ms=18000 # 会话超时时间(默认18秒)

# 生产环境建议:10-20秒

zookeeper.connection.timeout.ms=15000 # 连接超时时间

zookeeper.max.in.flight.requests=10 # 最大飞行请求数

# Controller端配置

controller.socket.timeout.ms=30000 # Controller与Broker的socket超时

# 计算公式:

实际故障检测时间 ≈ max(

zookeeper.session.timeout.ms,

controller.socket.timeout.ms

)副本同步状态检查(Replica Synchronization)

如果节点是个follower,他必须能及时的同步leader的写操作,延时不能太久,注意,这里的同步,同步的是isr中的follower节点。

ISR机制中的健康检查

副本同步作为健康检查的代理:

正常情况:

┌─────────────────────────────────────────────────────────┐

│ Controller │

│ │

│ 定期发送LeaderAndIsr请求到Broker │

│ (更新分区元数据、ISR信息) │

│ │

│ ↓ 请求成功 → Broker正常 │

│ ↓ 请求失败 → Broker可能有问题 │

└──────────────────────────┬──────────────────────────────┘

│

┌────────────────┼────────────────┐

│ │ │

▼ ▼ ▼

┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐

│ Broker1 │ │ Broker2 │ │ Broker3 │

│ │ │ │ │ │

│ Partition0: L │ │ Partition0: F │ │ Partition0: F │

│ Partition1: F │ │ Partition1: L │ │ Partition1: F │

│ │ │ │ │ │

│ ISR: [1,2,3] │ │ ISR: [2,1,3] │ │ ISR: [3,1,2] │

└─────────────────┘ └─────────────────┘ └─────────────────┘

│ │ │

└───────────────────┼───────────────────┘

│

Follower定期从Leader拉取数据

拉取成功 → 副本健康

拉取失败 → 副本可能不健康

异常检测场景:

场景1:网络分区导致Broker孤立

Broker1可以连ZooKeeper,但不能连其他Broker

• ZooKeeper会话:正常 ✓

• 副本同步:失败 ✗(无法从Leader拉取数据)

• 结果:被移出ISR,但Broker本身可能还"活着"

场景2:磁盘故障导致写入失败

Broker2可以通信,但磁盘无法写入

• ZooKeeper会话:正常 ✓

• 副本同步:失败 ✗(无法写入新数据)

• 结果:副本落后,被移出ISR

场景3:CPU死锁或GC停顿

Broker3进程还在,但不响应请求

• ZooKeeper会话:可能过期(心跳线程停止)

• 副本同步:停止 ✗

• 结果:最终被标记为死亡Kafa consumer是否可以消费指定分区消息?

Kafa consumer消费消息时,向broker发出"fetch"请求去消费特定分区的消息,consumer指定消息在日志中的偏移量(offset),就可以消费从这个位置开始的消息,customer拥有了offset的控制权,可以向后回滚去重新消费之前的消息,这是很有意义的,但是这样必须使用kafka低级API去做,分区和offset的控制完全交给了应用程序;

手动分配分区(Manual Partition Assignment)

import org.apache.kafka.clients.consumer.KafkaConsumer;

import org.apache.kafka.common.TopicPartition;

import java.util.Arrays;

import java.util.Properties;

public class ManualPartitionConsumer {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

// 注意:手动分配分区时不需要设置group.id

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 手动指定消费的分区

TopicPartition partition0 = new TopicPartition("my-topic", 0);

TopicPartition partition2 = new TopicPartition("my-topic", 2);

// 分配指定分区

consumer.assign(Arrays.asList(partition0, partition2));

// 可以指定起始偏移量

consumer.seek(partition0, 100); // 从分区0的偏移量100开始消费

consumer.seek(partition2, 0); // 从分区2的起始位置开始消费

try {

while (true) {

// 拉取数据

ConsumerRecords<String, String> records = consumer.poll(100);

for (ConsumerRecord<String, String> record : records) {

System.out.printf("Partition=%d, Offset=%d, Key=%s, Value=%s%n",

record.partition(),

record.offset(),

record.key(),

record.value());

}

}

} finally {

consumer.close();

}

}

}注意事项

没有消费组协调器

- 手动分配时,Kafka不会使用消费组协调器(GroupCoordinator)

- 因此不会进行自动的负载均衡和故障转移

偏移量需要自己管理

- 不会自动提交偏移量,需要手动管理

Map<TopicPartition, OffsetAndMetadata> currentOffsets = new HashMap<>();

- 不会自动提交偏移量,需要手动管理

多个消费者可以消费相同分区

- 不同于消费组模式,这里允许多个消费者消费相同分区

- 可能造成重复消费,需要业务逻辑处理

分区变化不会自动响应

- 如果Topic增加了新分区,不会自动分配到新分区

- 需要手动重新分配

适合场景:

- 需要精确控制消费哪些分区

- 状态恢复或重放特定分区数据

- 消费者数量固定的场景

- 需要独立处理每个分区的数据

使用消费组但指定分区子集

public class FilteredPartitionConsumer {

// 方法1:使用assign()但仍属于消费组

public void assignWithGroup() {

Properties props = new Properties();

props.put("group.id", "my-consumer-group"); // 仍然设置group.id

props.put("enable.auto.commit", "false"); // 手动提交偏移量

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 手动分配分区

List<TopicPartition> partitions = Arrays.asList(

new TopicPartition("my-topic", 0),

new TopicPartition("my-topic", 2)

);

consumer.assign(partitions);

// 注意:即使设置了group.id,也不会自动平衡

// 其他消费者可以加入同一组,但不会自动重新分配

}

// 方法2:订阅整个Topic,然后暂停不需要的分区

public void subscribeThenPause() {

Properties props = new Properties();

props.put("group.id", "my-consumer-group");

props.put("enable.auto.commit", "true");

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 订阅整个Topic

consumer.subscribe(Arrays.asList("my-topic"));

// 等待分配分区

Set<TopicPartition> assignedPartitions = null;

while (assignedPartitions == null || assignedPartitions.isEmpty()) {

consumer.poll(Duration.ofMillis(100));

assignedPartitions = consumer.assignment();

}

// 暂停不需要的分区(如分区1)

for (TopicPartition partition : assignedPartitions) {

if (partition.partition() == 1) {

consumer.pause(Arrays.asList(partition));

System.out.println("Paused partition: " + partition);

}

}

// 继续消费其他分区

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

// 这里只会收到未暂停分区的数据

}

}

}自定义分区分配策略

// 实现自定义的分区分配策略

public class CustomAssignor implements ConsumerPartitionAssignor {

@Override

public String name() {

return "custom-assignor";

}

@Override

public GroupAssignment assign(Cluster metadata, GroupSubscription groupSubscription) {

Map<String, Subscription> subscriptions = groupSubscription.groupSubscription();

Map<String, List<TopicPartition>> assignment = new HashMap<>();

// 遍历所有消费者

for (Map.Entry<String, Subscription> entry : subscriptions.entrySet()) {

String consumerId = entry.getKey();

Subscription subscription = entry.getValue();

// 获取消费者指定的分区列表(通过用户数据传递)

ByteBuffer userData = subscription.userData();

List<TopicPartition> preferredPartitions = deserializePreferredPartitions(userData);

if (preferredPartitions != null && !preferredPartitions.isEmpty()) {

// 使用消费者指定的分区

assignment.put(consumerId, preferredPartitions);

} else {

// 回退到默认策略

assignment.put(consumerId, getDefaultAssignment(consumerId, subscription, metadata));

}

}

return new GroupAssignment(assignment);

}

private List<TopicPartition> deserializePreferredPartitions(ByteBuffer userData) {

// 反序列化消费者指定的分区列表

if (userData == null || userData.remaining() == 0) {

return Collections.emptyList();

}

// 实现反序列化逻辑

return new ArrayList<>();

}

@Override

public List<RebalanceProtocol> supportedProtocols() {

return Arrays.asList(RebalanceProtocol.EAGER);

}

@Override

public void onAssignment(Assignment assignment, ConsumerGroupMetadata metadata) {

// 分配完成后的回调

}

@Override

public Subscription subscription(Set<String> topics) {

// 构建订阅信息

return new Subscription(new ArrayList<>(topics), null);

}

}

// 使用自定义分配器

public class UseCustomAssignor {

public static void main(String[] args) {

Properties props = new Properties();

props.put("partition.assignment.strategy", CustomAssignor.class.getName());

// ... 其他配置

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Arrays.asList("my-topic"));

}

}指定起始偏移量消费

精确控制消费位置

public class SpecifyOffsetConsumer {

// 方法1:从指定偏移量开始

public void consumeFromSpecificOffset() {

KafkaConsumer<String, String> consumer = createConsumer();

TopicPartition partition = new TopicPartition("my-topic", 0);

consumer.assign(Arrays.asList(partition));

// 1. 从绝对偏移量开始

consumer.seek(partition, 1000); // 从偏移量1000开始

// 2. 从相对位置开始

consumer.seekToBeginning(Arrays.asList(partition)); // 从最早开始

consumer.seekToEnd(Arrays.asList(partition)); // 从最新开始

// 3. 从时间戳开始

Map<TopicPartition, Long> timestampsToSearch = new HashMap<>();

timestampsToSearch.put(partition, System.currentTimeMillis() - 3600000); // 1小时前

Map<TopicPartition, OffsetAndTimestamp> offsets =

consumer.offsetsForTimes(timestampsToSearch);

if (offsets.get(partition) != null) {

consumer.seek(partition, offsets.get(partition).offset());

}

}

// 方法2:使用seek()进行重放

public void replaySpecificRange() {

KafkaConsumer<String, String> consumer = createConsumer();

TopicPartition partition = new TopicPartition("my-topic", 0);

consumer.assign(Arrays.asList(partition));

// 获取分区范围

Map<TopicPartition, Long> beginningOffsets =

consumer.beginningOffsets(Arrays.asList(partition));

Map<TopicPartition, Long> endOffsets =

consumer.endOffsets(Arrays.asList(partition));

long start = beginningOffsets.get(partition);

long end = endOffsets.get(partition);

// 重放特定范围(如最后的1000条消息)

long replayStart = Math.max(start, end - 1000);

consumer.seek(partition, replayStart);

// 消费直到指定位置

while (true) {

ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));

for (ConsumerRecord<String, String> record : records) {

if (record.offset() >= end) {

return; // 达到结束位置

}

processRecord(record);

}

}

}

}消费模式对比

┌─────────────────┬────────────────────────────────┬────────────────────────────────┐

│ 特性 │ 消费组模式 (subscribe()) │ 手动分配模式 (assign()) │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 分区分配 │ 自动,由GroupCoordinator分配 │ 手动指定 │

│ │ 策略:Range/RoundRobin/Sticky │ │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 负载均衡 │ 自动均衡 │ 无自动均衡 │

│ │ 消费者增减时自动重新分配 │ 需要手动管理 │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 故障恢复 │ 自动故障转移 │ 无自动故障转移 │

│ │ 消费者故障时分区重新分配 │ 消费者故障时分区停止消费 │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 偏移量管理 │ 自动或手动提交到__consumer_ │ 需要完全手动管理 │

│ │ offsets Topic │ 可存储到外部系统 │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 重复消费控制 │ 通过偏移量保证至少一次 │ 需要业务逻辑保证 │

│ │ 或精确一次语义 │ │

├─────────────────┼────────────────────────────────┼────────────────────────────────┤

│ 适用场景 │ • 常规消费场景 │ • 需要精确控制分区 │

│ │ • 动态伸缩需求 │ • 状态恢复/数据重放 │

│ │ • 高可用要求 │ • 固定消费者数量的场景 │

│ │ • 无状态消费者 │ • 需要跨消费组共享数据 │

└─────────────────┴────────────────────────────────┴────────────────────────────────┘producer是否直接将数据发送到broker的leader(主节点)?

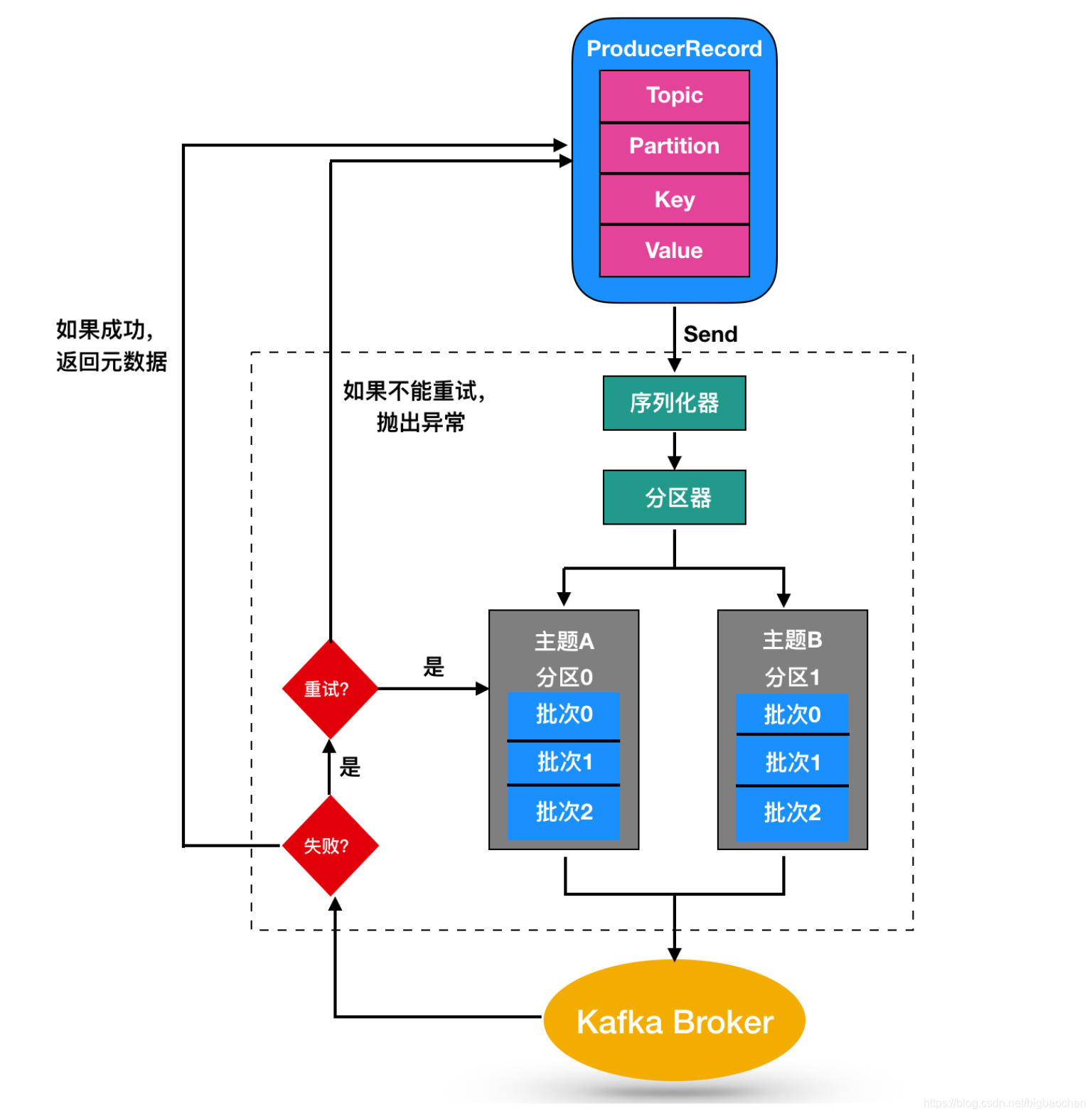

本质问的是kafkaz生产者发送数据流程;

producer直接将数据发送到topic的leader(主节点),不需要在多个节点进行分发,为了帮助producer做到这点,所有的Kafka节点都可以及时的告知:哪些节点是活动的,目标topic目标分区的leader在哪。这样producer就可以直接将消息发送到目的地了。

Kafka生产者默认直接发送数据到对应分区的Leader副本,这是Kafka高性能设计的核心之一。

kafka生产者发送数据主流程

// 生产者发送数据的基本流程

public class ProducerSendFlow {

public void sendMessage() {

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

// 当调用send()时:

// 1. 序列化消息

// 2. 计算分区(如果未指定)

// 3. 找到分区Leader所在的Broker

// 4. 直接发送到Leader

producer.send(new ProducerRecord<>("my-topic", "key", "value"));

}

}元数据获取与Leader发现

// 生产者内部元数据管理

public class ProducerMetadataManager {

private final Metadata metadata; // 元数据缓存

private final Cluster cluster; // 集群状态

// 获取分区Leader的完整流程

public Node getPartitionLeader(String topic, Integer partition) {

// 1. 检查本地元数据缓存

Cluster currentCluster = metadata.fetch();

// 2. 如果缓存中没有或已过期,则更新元数据

if (currentCluster == null || metadata.timeToNextUpdate() <= 0) {

// 触发元数据更新请求

metadata.requestUpdate();

currentCluster = metadata.fetch();

}

// 3. 获取分区Leader信息

PartitionInfo partitionInfo = currentCluster.partition(topic, partition);

if (partitionInfo == null) {

// 分区不存在,需要刷新元数据

metadata.requestUpdate();

currentCluster = metadata.fetch();

partitionInfo = currentCluster.partition(topic, partition);

}

// 4. 返回Leader节点

return partitionInfo.leader();

}

// 元数据内容结构

class PartitionInfo {

private final int partition;

private final Node leader; // Leader节点

private final Node[] replicas; // 所有副本

private final Node[] inSyncReplicas; // 同步副本

// Leader可能为null(分区无Leader时)

public Node leader() {

return leader;

}

}

}数据发送详细流程

生产者发送数据完整流程:

┌─────────────────────────────────────────────────────────┐

│ Kafka Producer │

├─────────────────────────────────────────────────────────┤

│ 1. Producer.send(record) │

│ ↓ │

│ 2. 序列化Key/Value │

│ ↓ │

│ 3. 分区选择 (partitioner.partition()) │

│ ├─ 如果指定了分区:使用指定分区 │

│ ├─ 如果有Key:hash(Key) % numPartitions │

│ └─ 无Key:轮询或粘性分区 │

│ ↓ │

│ 4. 元数据查询 (metadata.fetch()) │

│ ├─ 缓存命中 → 直接获取Leader │

│ └─ 缓存未命中 → 向任意Broker请求元数据 │

│ ↓ │

│ 5. 构建发送批次 (RecordAccumulator) │

│ ├─ 按Broker分组批次 │

│ ├─ 压缩 (如果配置) │

│ └─ 等待批次满或超时 │

│ ↓ │

│ 6. 网络发送 (Sender线程) │

│ └─ 直接发送到对应分区的Leader Broker │

└───────────────────────────┬─────────────────────────────┘

│

▼

┌─────────────────────────────────────────────────────────┐

│ Kafka Broker (Leader) │

├─────────────────────────────────────────────────────────┤

│ 1. 接收生产请求 │

│ 2. 验证请求权限 │

│ 3. 写入本地日志 (Leader副本) │

│ 4. 根据acks配置等待Follower同步 │

│ 5. 发送响应给Producer │

└───────────────────────────┬─────────────────────────────┘

│ 异步复制

▼

┌─────────────────────────────────────────────────────────┐

│ Follower Brokers │

├─────────────────────────────────────────────────────────┤

│ 定期从Leader拉取数据并写入本地日志 │

└─────────────────────────────────────────────────────────┘生产者如何找到分区的Ledaer

元数据缓存机制

// 生产者元数据缓存工作方式

public class MetadataCacheMechanism {

// 元数据更新过程

public void updateMetadata() {

// 初始连接:通过bootstrap.servers连接任意Broker

List<InetSocketAddress> addresses = parseBootstrapServers();

// 选择第一个可用的Broker发送MetadataRequest

for (InetSocketAddress address : addresses) {

try {

NetworkClient client = createNetworkClient(address);

// 请求集群元数据

MetadataResponse response = client.sendMetadataRequest(

Arrays.asList("interested-topics") // 感兴趣的主题

);

// 解析响应,更新缓存

Cluster cluster = parseMetadataResponse(response);

metadata.update(cluster, time.milliseconds());

break; // 成功后退出循环

} catch (Exception e) {

// 尝试下一个地址

continue;

}

}

}

// 元数据缓存内容

class CachedMetadata {

Map<String, List<PartitionInfo>> topicPartitions; // 主题分区信息

Map<Integer, Node> nodes; // Broker节点信息

long lastUpdateTime; // 最后更新时间

long ttl; // 缓存有效期

// 检查是否需要更新

public boolean needsUpdate() {

// 触发更新的条件:

// 1. 缓存过期 (metadata.max.age.ms,默认5分钟)